目次

はじめに

こんにちは、Recruit Data Blog担当の森です。

2025年8月1日に、当社のアナリティクスエンジニア3名が登壇するイベント「アナリティクスエンジニアが語る第2弾 ~事業成長を牽引するデータマネジメント~」を開催しました。(

こちら

)

さらにアフタートークの配信も予定しています。

本記事では、イベントの開催背景や当日の内容を振り返りつつ、アフタートークの詳細もご案内します。ぜひ最後までご覧ください。

1. イベント開催のきっかけと目的

本イベントは、過去に開催した第1弾が大好評だったことを受け、第2弾として開催に至りました。(第1弾についてのblogは こちら )

今回は「データマネジメント」をキーワードに、実際のプロジェクト事例を通じて、リクルートのアナリティクスエンジニア(以下「AE」)がどのように事業を支えているのかをお伝えしました。

2. イベント概要

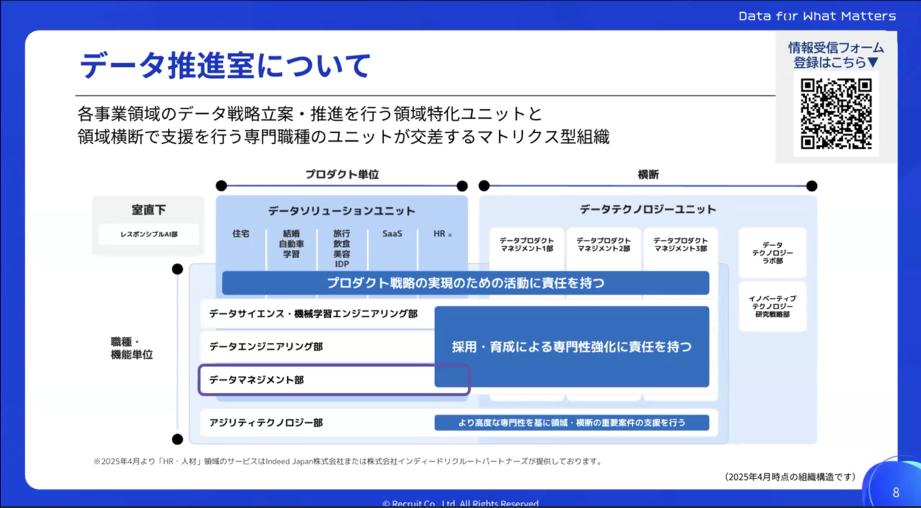

当日はデータ推進室 データマネジメント部 アナリティクスエンジニアグループに所属するグループマネージャーの新堀がモデレーターを務め、各事業領域からAEとして活躍する3名が登壇しました。

イベントは以下のスケジュールで進行しました。

- 19:00~19:05 オープニング

- 19:05~19:20 「今この瞬間の正しい情報」によって実現するレコメンドシステム

- 19:20~19:35 ゆるやかに移行するディメンショナルモデリング

- 19:35~19:50 事業を支える多層モニタリング×データマネジメント

- 19:50~20:00 クロージング

2-1. 「今この瞬間の正しい情報」によって実現するレコメンドシステム(森田)

トップバッターは、自動車データソリューショングループに所属する森田が務めました。現在『カーセンサー』『ゼクシィ』などのメディア事業において、データ活用を推進しています。

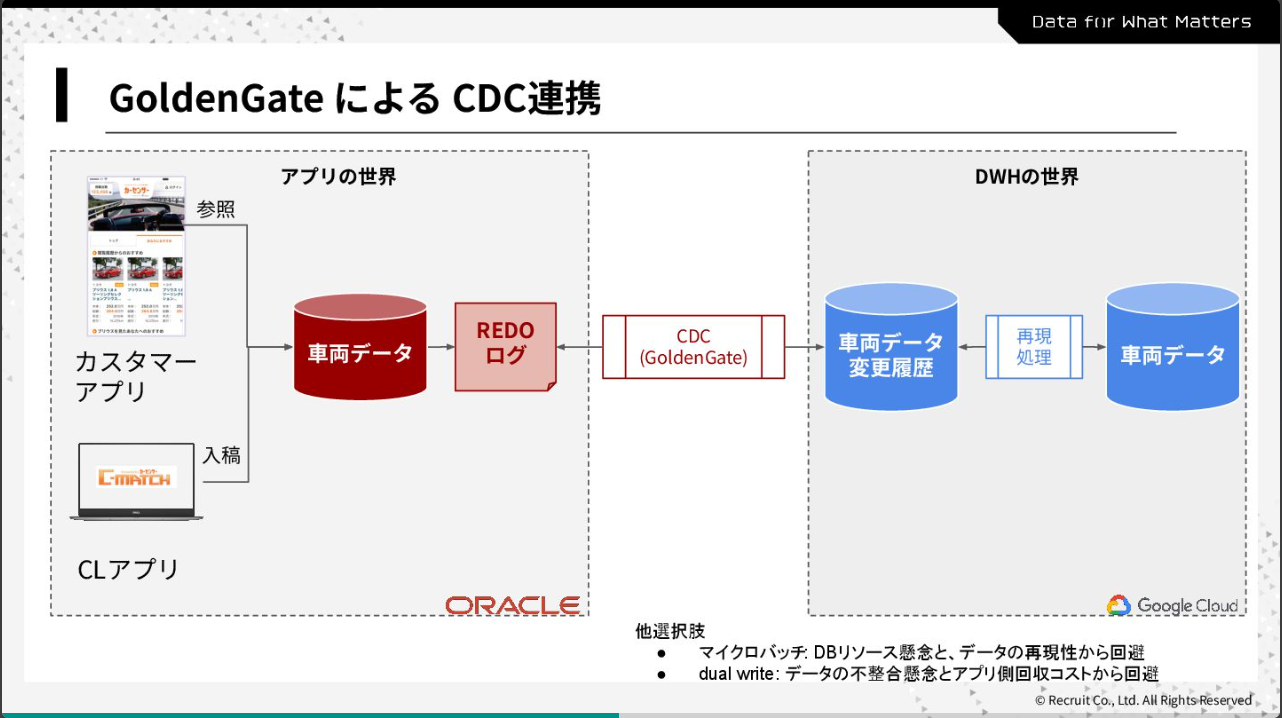

本事例では『カーセンサー』におけるGolden Gateを用いたChange Data Captureの導入と運用について、以下のアジェンダで紹介しました。

- カーセンサーの競争力であるレコメンドシステムとそれを支えるデータ

- レコメンドにおけるデータ鮮度の重要性

- CDCを導入する課題と工夫と責務

『カーセンサー』においてレコメンドは、車に詳しくない方でも理想の車を見つけられるようにする重要な仕組みです。リクルートは質・量ともに最大級のデータを保有し、これを競争力の源泉としています。 その中でも特に重要となるのがデータの鮮度です。データが古いと、レコメンドに表示される物件の質や量が低下してしまいます。この課題に対応するため、Change Data Capture(以下「CDC」)を導入しました。

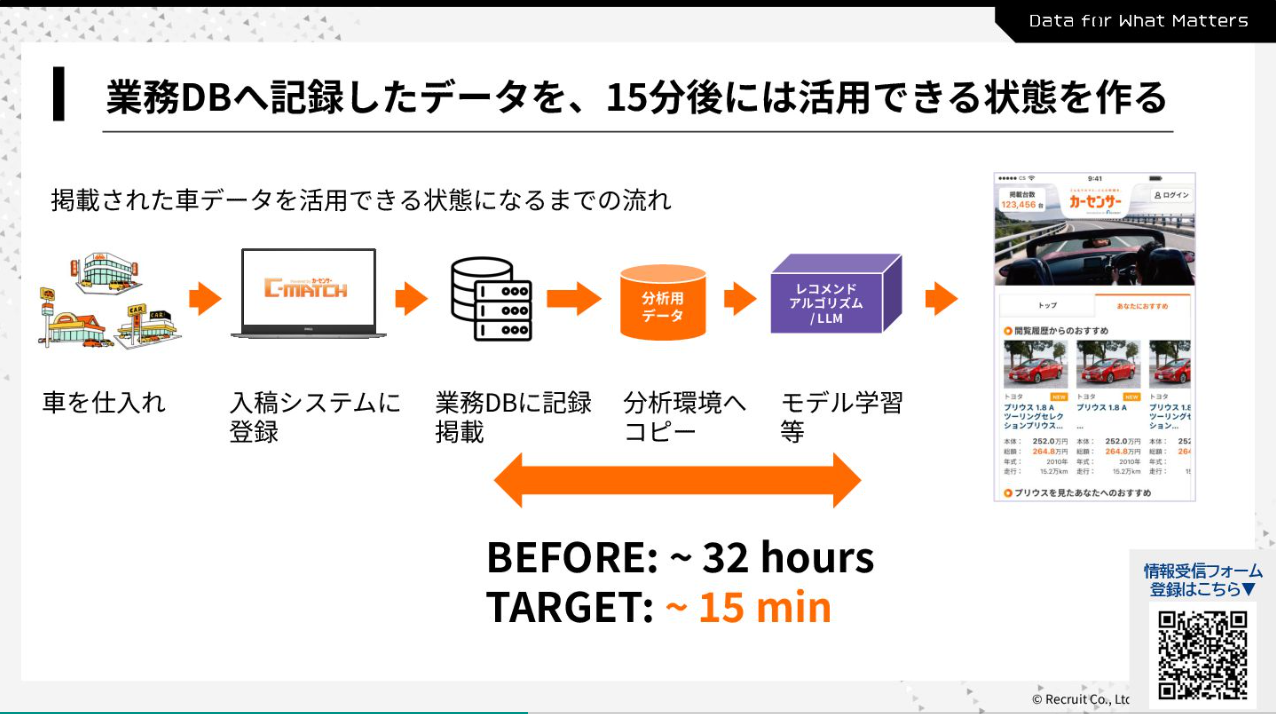

掲載された車データがレコメンドに活用可能となるまでの流れは、以下の図に示す通りです。

今回のポイントは、GoldenGateという仕組みを用いたCDCの導入により、データ伝搬のリードタイムを大幅に短縮できたことです。これまで最大で32時間かかっていたところを、15分以内で反映できるようになりました。

CDCはアプリ用データで発生した変更(CRUD)を、分析用のテーブルに伝搬させる機能です。

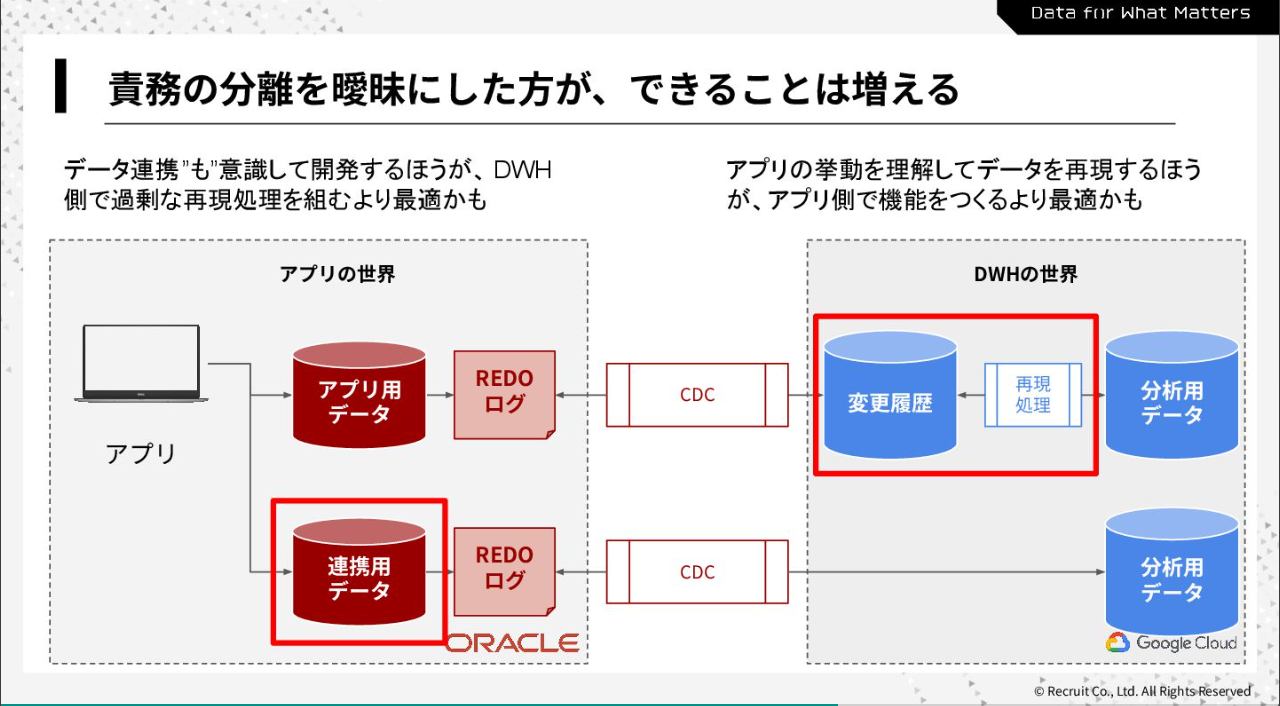

ただし、変更をそのまま伝搬しても期待するデータを連携できるわけではありません。

必要に応じて、アプリ側・DWH(データウェアハウス)側双方で、加工処理を行う必要がでてきます。ここは責務の分割に悩むところでしたが、全体最適を優先して双方で加工処理を担う形としました。

本取り組みの結果、連携鮮度を32時間から15分以内へと大幅に短縮しただけでなく、以下のような成果も出すことができました。

- レコメンドの精度が高まり、より多くのカスタマーに最適な車を届けられるようになった

- APP側とDWH側の双方が染み出すことで、リクルート全体で動くoracleDBのデータをニアリアルタイムで連携する前例を築いた

最後に森田は、今回AEとして取り組む中で感じたリクルートの魅力について

- LLM時代に差別化の鍵となるデータを持つこと

- 専門性が存分に発揮できる土壌があること

があると語りました。

2-2.ゆるやかに移行するディメンショナルモデリング(岩井)

続いては、SaaSデータマネジメントグループに所属する岩井の発表でした。現在は主に『Airペイ』をはじめとする決済プロダクトのデータ活用推進、およびSaaS領域横断のデータマネジメント業務に従事しています。

本事例では、品質を改善しながらOne Big Tableを変革していくアプローチについて、以下のアジェンダで紹介しました。

- One Big Tableの限界

- One Big Tableの品質を高めるアプローチ

- ゆるやかにディメンショナルモデリングを進めるためのアプローチ ~データマート開発のプロセス整理とディメンショナルモデリングの推進~

Tips:開発を加速する取り組み

One Big Tableとは、分析に必要な情報を一つのテーブルに突合した巨大なテーブルです。長年の運用実績がある一方で、信頼性の揺らぎやブラックボックス化、高すぎる保守改修コストなどの課題を抱えていました。これらの課題の根本は、関連性の低い多数のビジネスロジックが、一つのテーブルに無理やり詰め込まれる構造にあると考えました。

そこでこの複雑な「構造」を解決するために、ディメンショナルモデリングを採用。高品質なテーブルの組み合わせにより、あらゆる分析ニーズに高速で応える世界を目指しました。

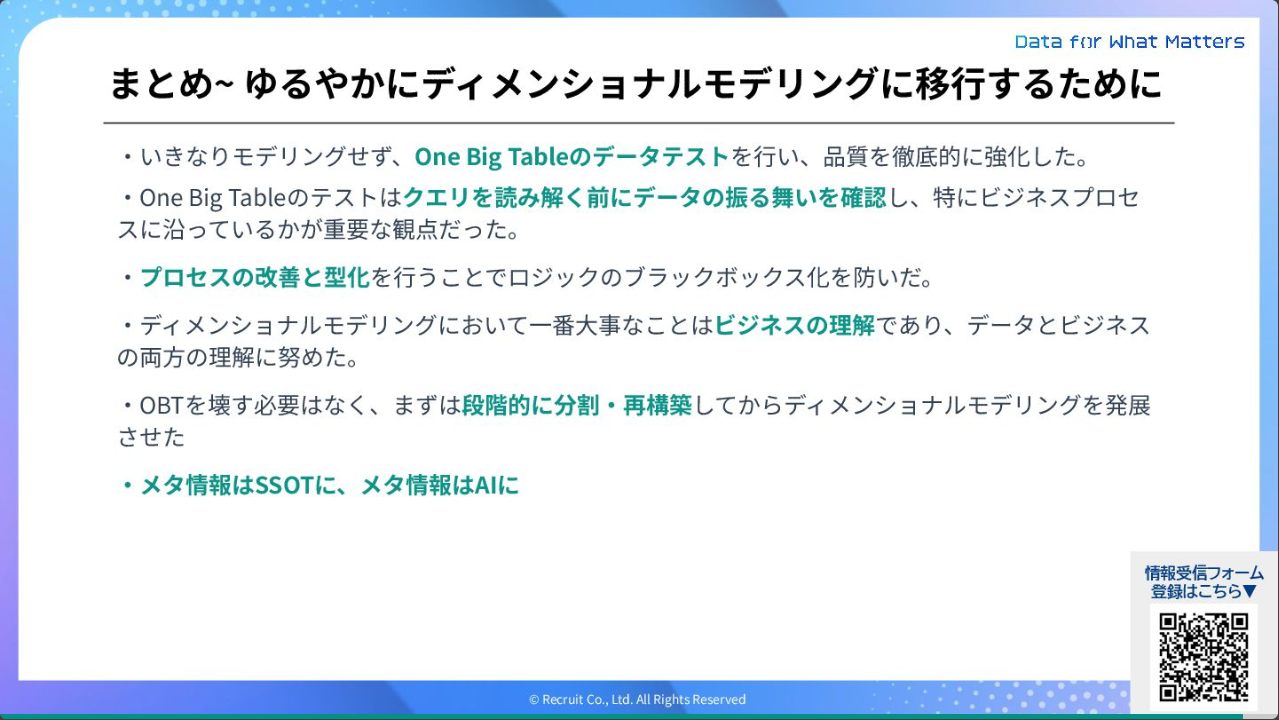

しかし現状ユーザーが多い One Big Tableを一気に廃止するのは非現実的。そこで全てを作り直して完璧な設計を待つのではなく、土台を固めてから緩やかに構造を変えていくためのアプローチをしました。 その具体策は以下の通りです。

- いきなりディメンショナルモデリングに着手するのではなく、まずは足元のデータの品質を高める

- ユーザー影響を出さないためにディメンショナルモデリングとOne Big Tableを併用する

- One Big Tableの内部処理をディメンション・ファクトのみで再現することをまずは目指す

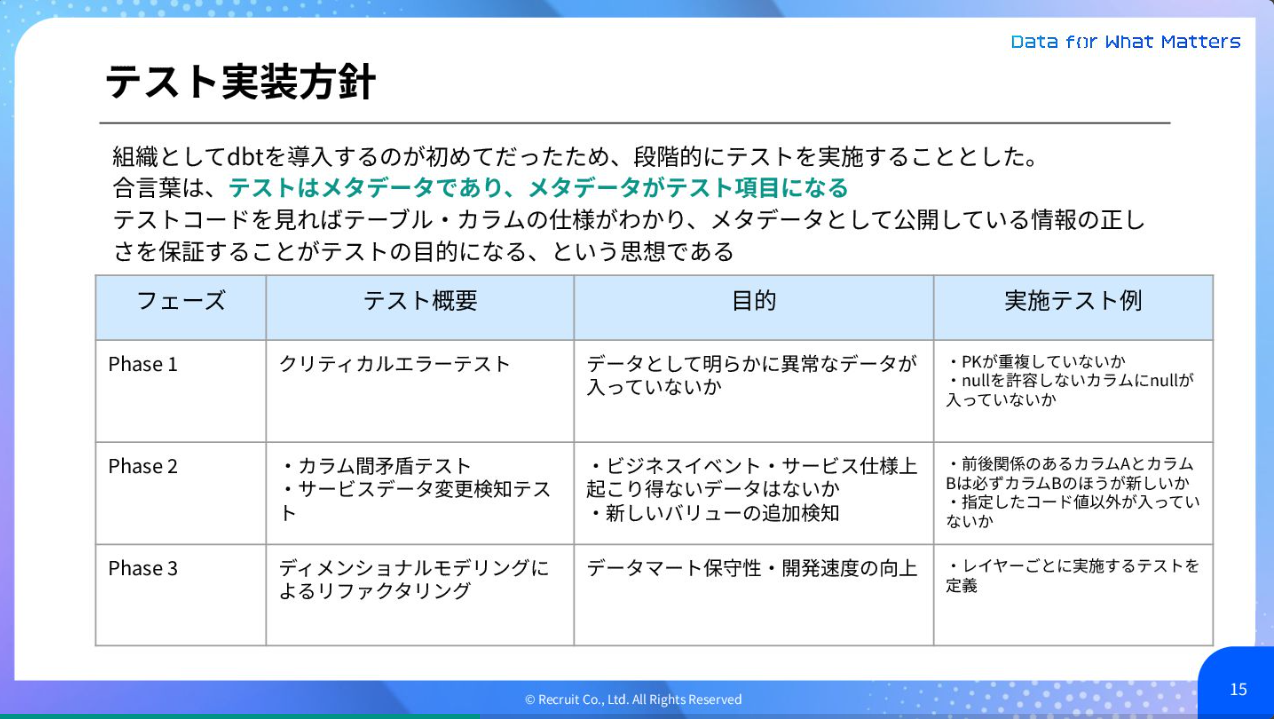

まずOne Big Tableの品質を高めるアプローチにおいては、dbtをテストのためだけに導入し、段階的にテストを実施しました。その結果、品質が初めて数値として可視化され、どこに問題があるのかを具体的かつ継続的に特定できるようになりました。

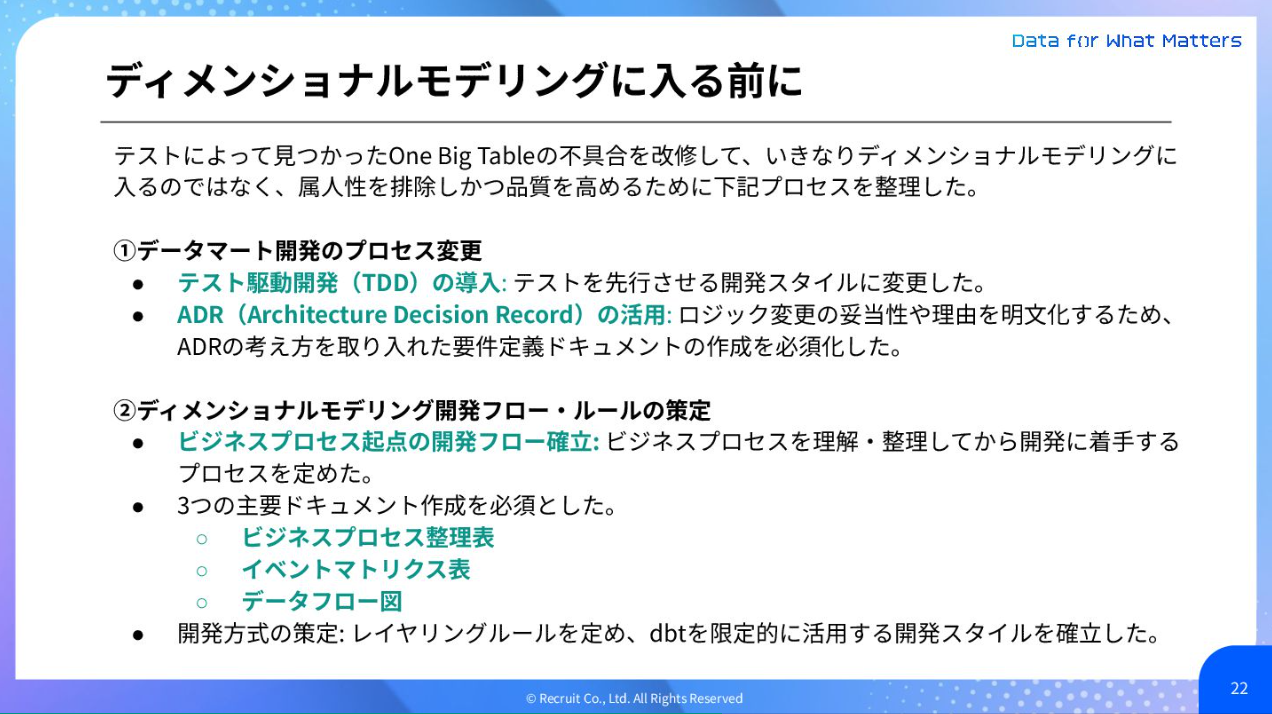

ディメンショナルモデリングに移行する前段階においては、データマート開発のプロセス変更と、ディメンショナルモデリング開発フロー・ルールの策定を行いました。

こうして品質を維持しながら、ディメンショナルモデリングへの移行を進める基盤を築きました。 その結果、巨大なOne Big Tableを、再利用可能でメンテナンスしやすい部品へと分割・再構築することに成功。既存のOne Big Tableをdimension/factの組み合わせで再現し、必要な情報を整理しながら品質を改善しつつ、ゆるやかな移行を実現しました。

現場の信頼感を維持しながら着実なステップを踏んで進めていく姿勢は、他の現場でも活かすことができそうです。

2-3. 事業を支える多層モニタリング×データマネジメント(木内)

最後の事例共有は、飲食・ビューティー・旅行データマネジメントグループに所属する木内が担当しました。現在は、各領域における分析基盤の開発運用とデータ利活用を推進しています。

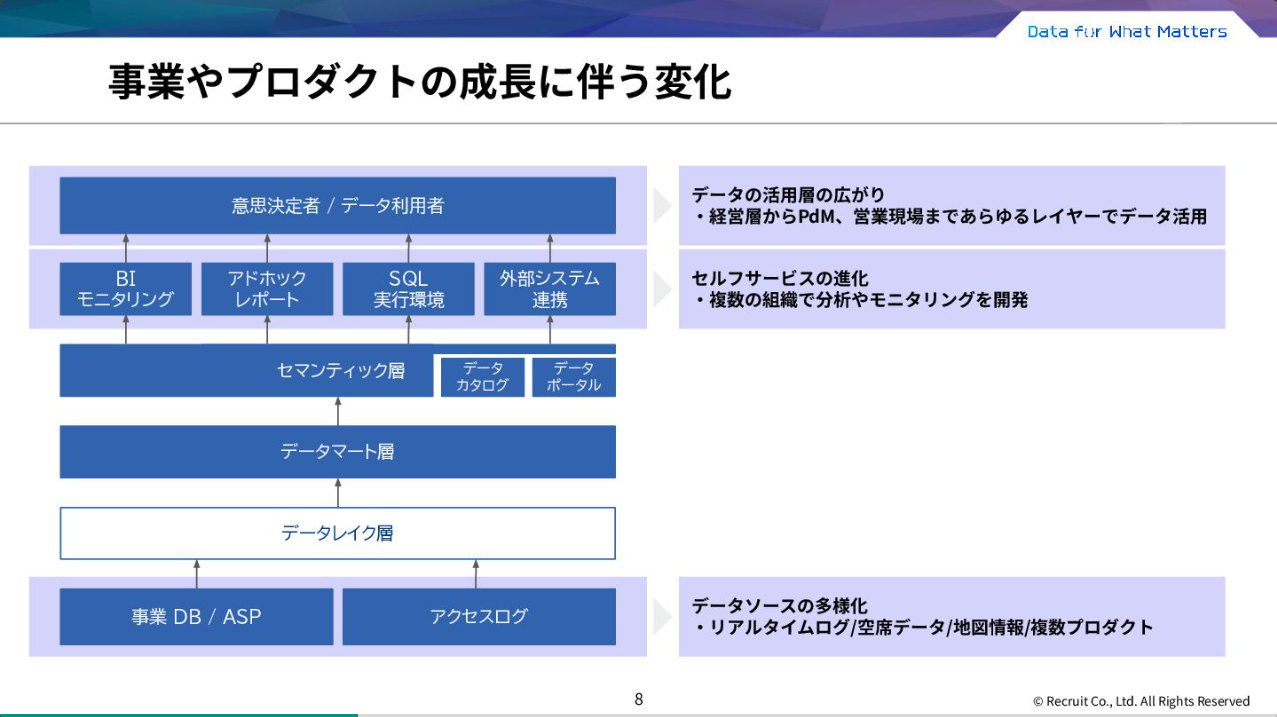

本事例では、事業やプロダクトの成長に伴い変化する「期待」に対し、‟守り”から‟攻め”の姿勢に転じた事例について、以下のアジェンダでご紹介しました。

- 飲食事業におけるデータマネジメントグループの役割と変遷

- 事業とデータマネジメント組織のGap

- ‟守り”から‟攻め”への転換

飲食事業の『ホットペッパーグルメ』では、事業やプロダクトの成長に伴い、モニタリングや分析の機能も高度化・多層化しています。短期的には多様なデータをより迅速に活用し、中長期的な戦略実現に向けては、データプロダクトの継続的な品質担保が求められるようになりました。

しかし求められる期待と現場の実態にはGapがありました。大量の案件ニーズに応えるため、依頼ベースで個別にモニタリングやデータマートを作成していたほか、短期案件に集中しすぎることで事業が求める品質やスピードに十分に適応できない状況となっていたのです。

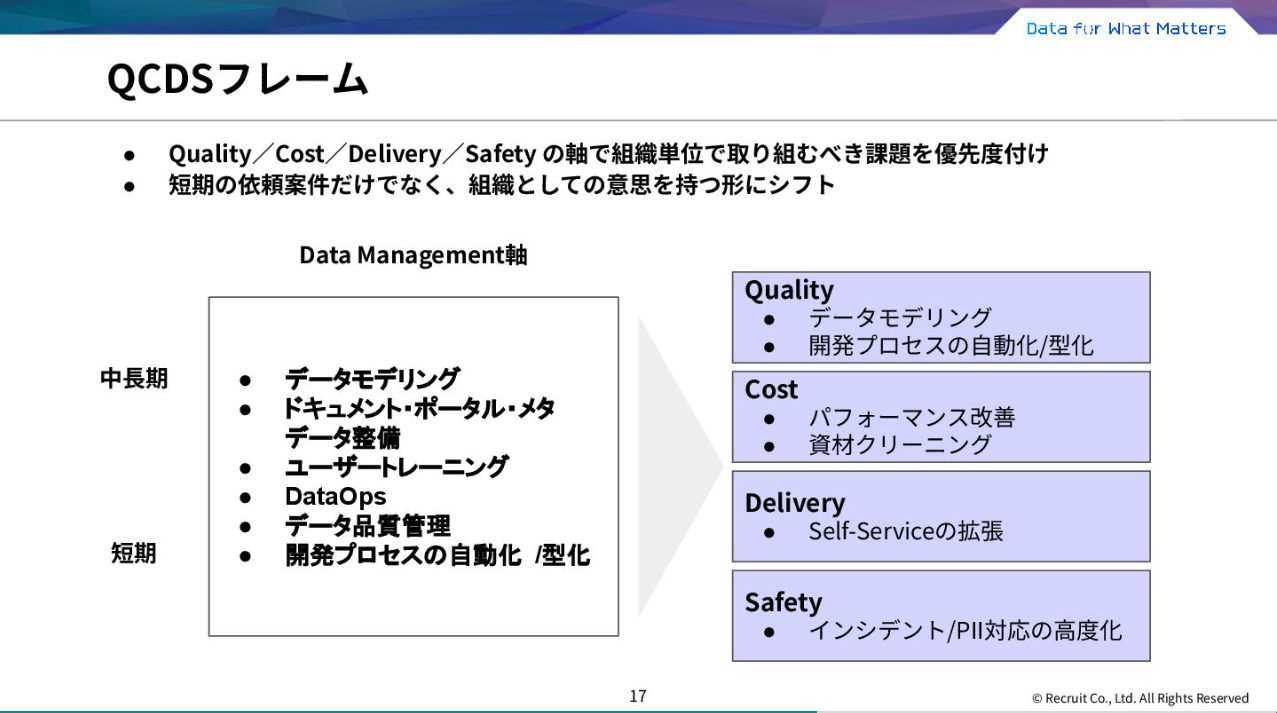

そこでまず組織改善チームを発足し、課題を「QCDS(Quality / Cost / Delivery / Safety)」の4軸で整理。優先度を明確にすることで、短期的な対応にとどまらず、中長期の視点を持った取り組みへとシフトしました。

さらに事業の中長期戦略と連動させ、既存業務からの脱却にも挑戦。データモデリングやレイヤリングの再定義も行いました。

データマネジメントグループは、これまでの依頼開発等を中心としていたところから、短期と中長期を両立する組織へと進化しています。これからはAIを活用してアナリティクスレディな環境作りに取り組んでいく予定です。現在は10名を超えるメンバーでデータ基盤改善に取り組んでおり、引き続き新しい仲間も募集しています。

3. アフタートークのご案内

ここからは本イベントのアフタートークをご案内します。

配信日は9月下旬公開予定。データ推進室 情報受信フォームに事前登録いただいた方限定で公開予定です。

▼ 登録フォーム

https://recruit-mid-career.my.salesforce-sites.com/career?id=a02Q900000hMmEvIAK

ご登録いただくと、今回の第2弾イベントのアーカイブ動画とスライド資料もご覧いただけます。このブログではかなり抜粋した情報をお届けしているので、ぜひご確認いただけたらと思います。

またアフタートークでは、イベント本編で語り切れなかった話や、AEとしてのやりがいや求められるスキル、挑戦していきたいこと…等をお届けします。現場で活躍するAEたちのリアルな想いや裏話に触れられる貴重な機会。ぜひご登録をお願いいたします。

※登録からアフタートーク配信まで、お時間をいただく場合がございます。あらかじめご了承ください。

おわりに

今回は「アナリティクスエンジニアが語る」第2弾の振り返りと、アフタートークのご案内をしました。

本イベントを通して、リクルートにおけるAEの現場での工夫や向き合う姿勢などについて、少しでも視聴者の皆様の現場でのヒントに繋がったり、ご興味を持っていただければ幸いです。

お知らせRECRUIT TECH CONFERENCE 2026を開催します!(オンライン配信/参加無料)

リクルート主催の技術カンファレンス。

第3回目となる今回は「AI×プロダクト開発」をテーマに、急速な技術進化の中で生まれた多様な領域のナレッジから、技術者の活躍を引き出す土壌づくりまで、豊富なセッションをお届けします。是非お気軽にご参加ください!

RECRUIT TECH CONFERENCE 2026

-

開催日時

2026年2月27日(金) 12:00~19:30 (オンライン配信/途中入退場自由) -

社外ゲスト

和田 卓人 氏(タワーズ・クエスト株式会社 取締役社長)/岡野原 大輔 氏(株式会社Preferred Networks 共同創業者 代表取締役社長) ※ご登壇順