目次

こんにちは。2017年度新卒webフロントエンジニアの夛田(@itsukichang)です。

先日に引き続き『Adobe MAX 2017』に参加しています。今回はMAX2日目に行われたSneaksの内容をレポートします。

昨年の記事でも紹介されていましたが、SneaksはAdobeの最新研究開発情報についてデモを交えての発表で伝えてくれるセッションです。

今年は大人気海外ドラマ『シリコンバレー』の俳優でおなじみのKumail Nanjiani氏を迎えての発表。

マリオや8bitをテーマとしたコミカルな装飾がなされた会場にて、現在Adobeが取り組んでいる最新の技術発表が次々と行われました。

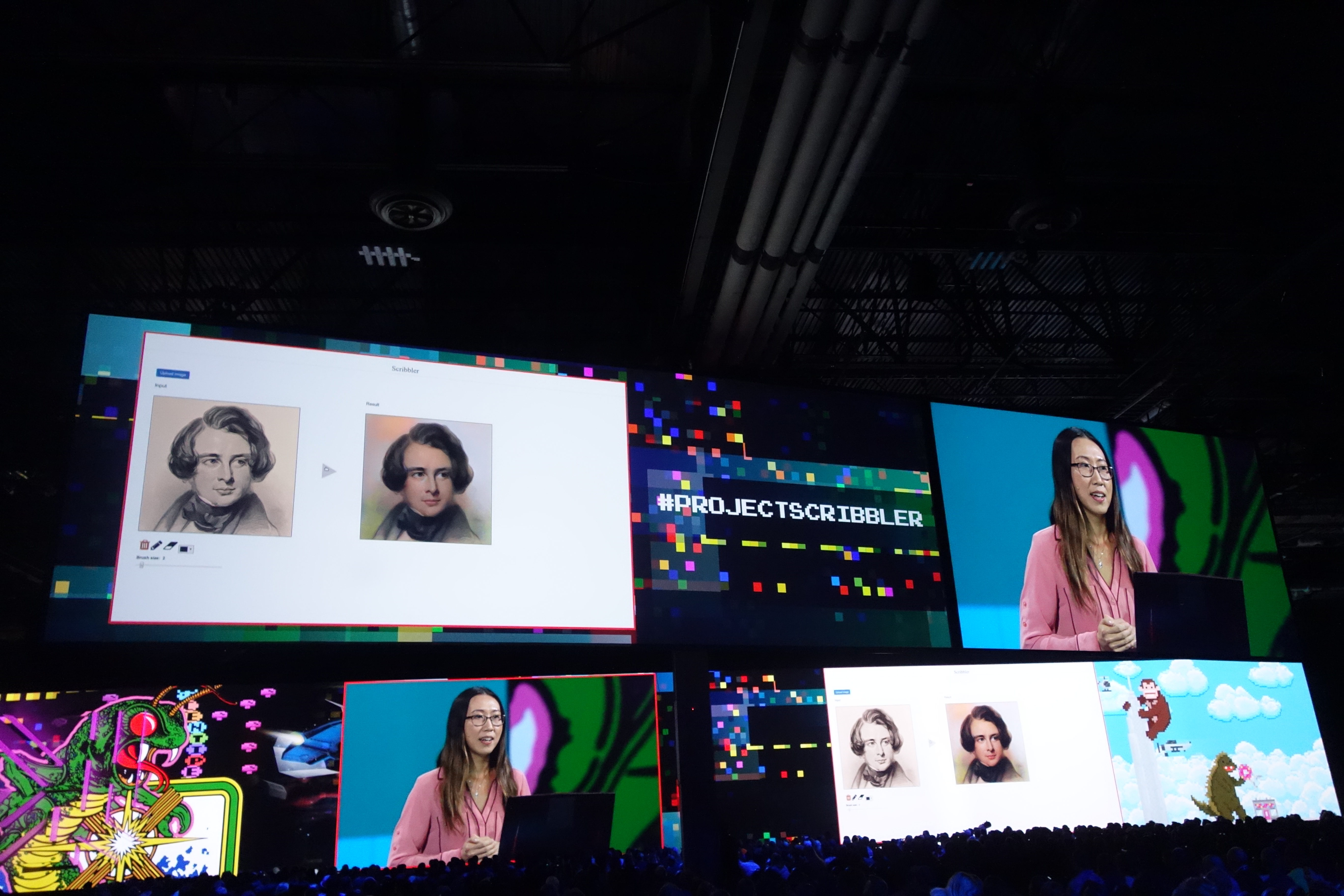

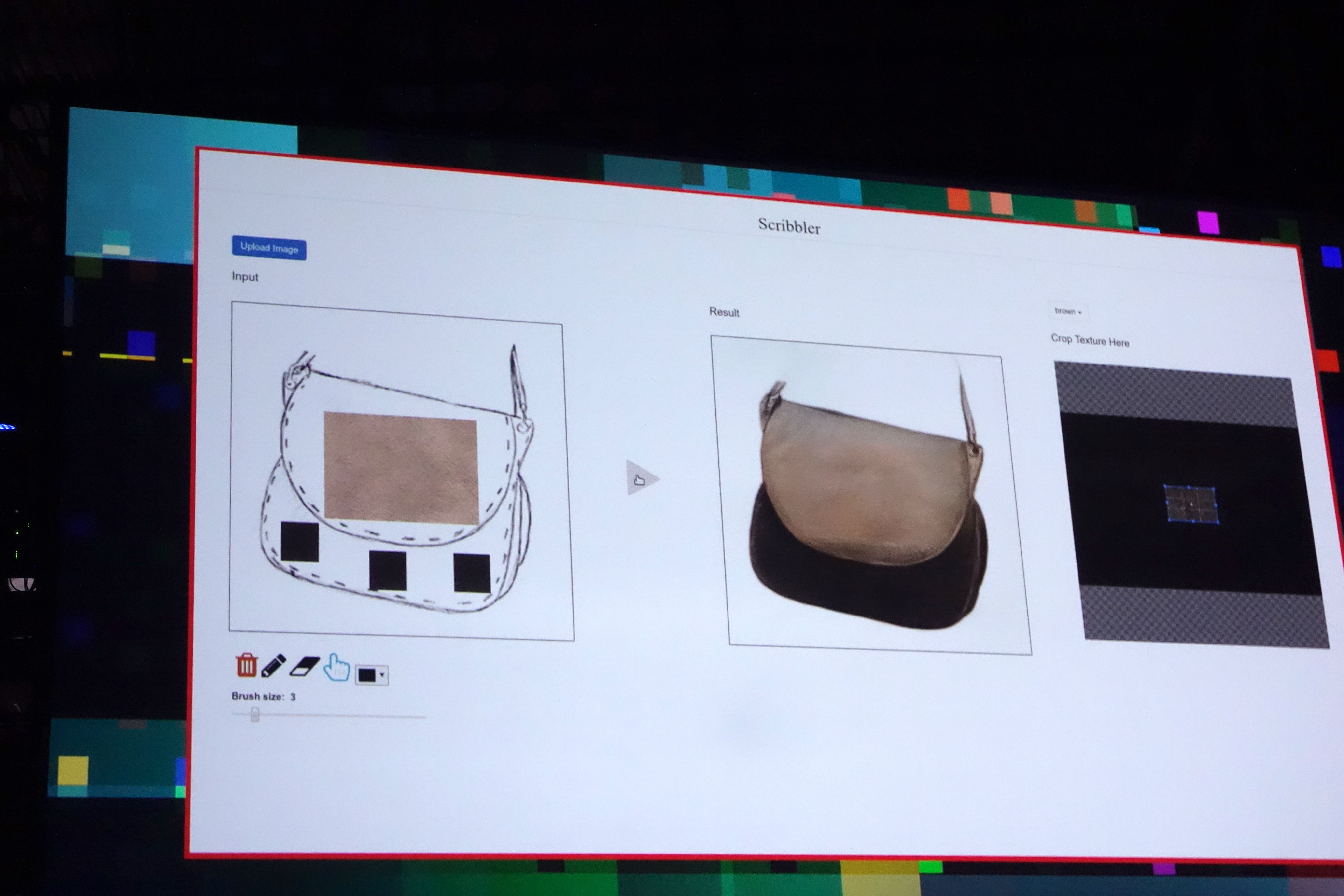

1.#SCRIBBLER

モノクロの肖像画や写真から色を復元する技術です。単純な着色だけではなく、ユーザが選んだテクスチャを元にリアルな質感を再現していました。

Adobe Senseiのニューラルネットワークを使用して大量の写真から適切な色ぬりを学習しているそうです。

2.#Scencestich

写真の選択した部分を他の物に置き換えてしまう技術です。近いものですとPhotoshopの「Content-Aware」というメソッドがあります。しかし「Content-Aware」は同写真内から自然な埋め合わせパターンを反映させるのに対し、今回発表された「Scencestich」はAdobe Stock内にある1億は超える写真の中から最適な合成編集を行います。

こちらの技術においても、Adobe Senseiの機械学習が活用されているそうです。

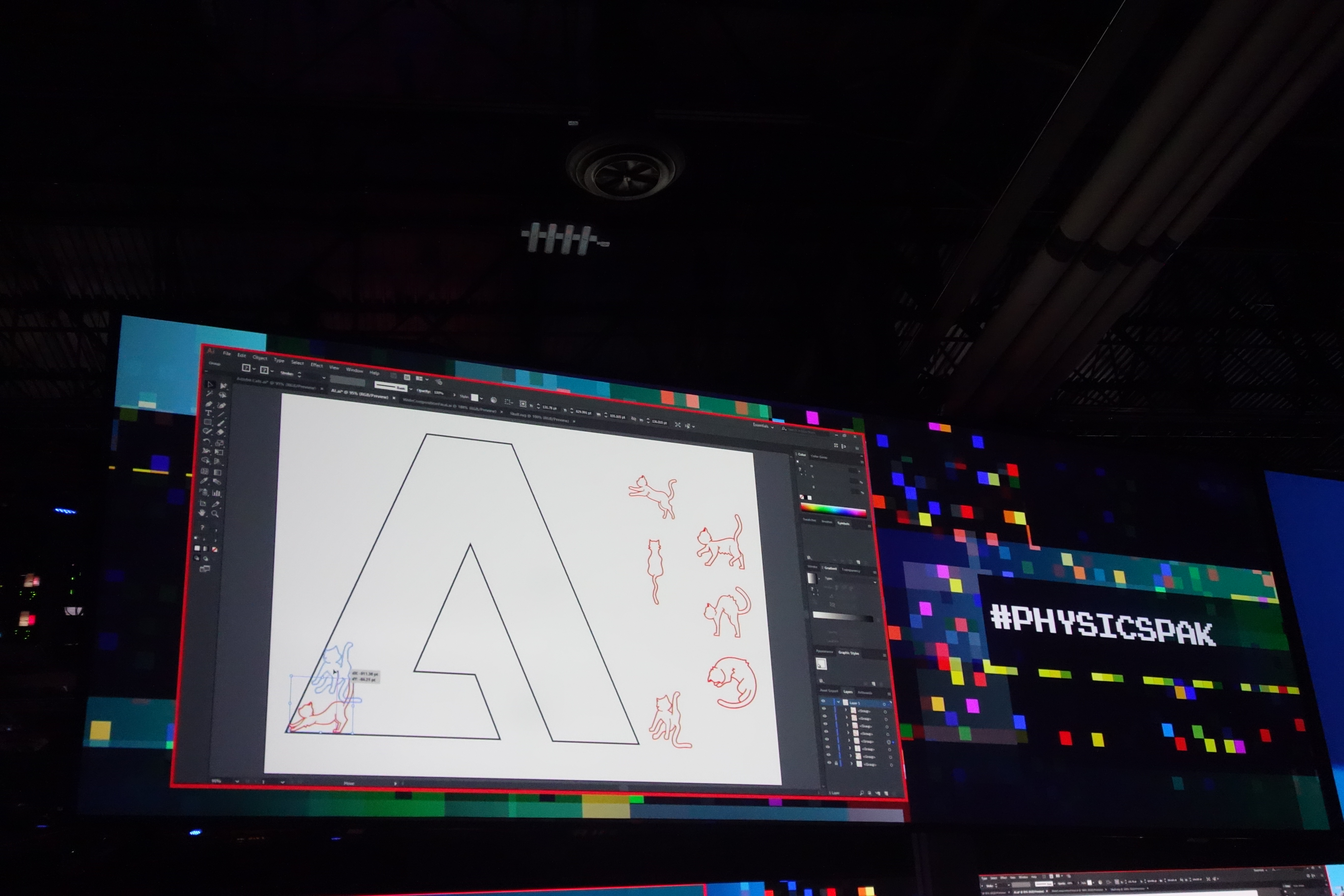

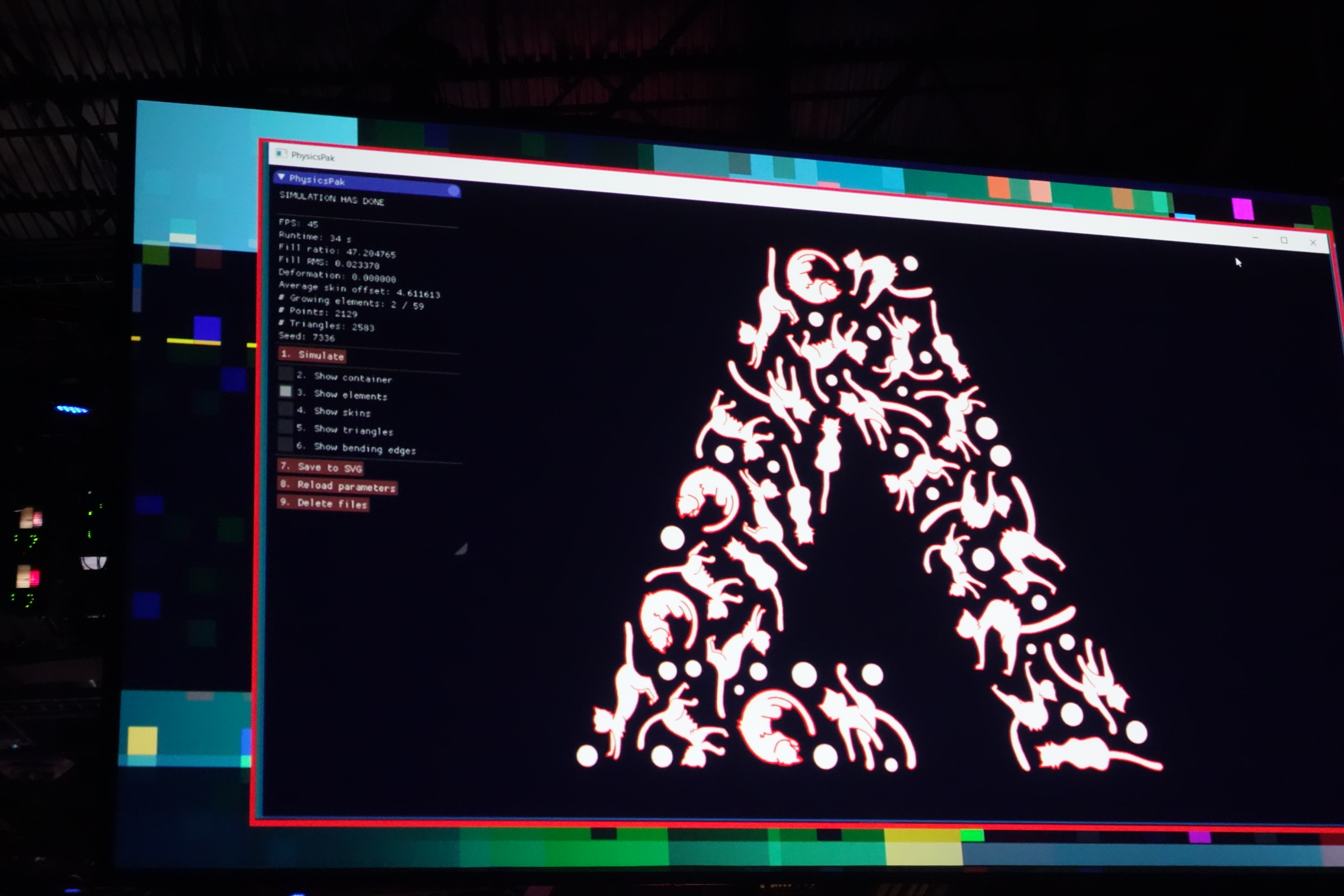

3.#Physicspak

ベクターデータ中に別の要素を敷き詰める作業を衝突判定等の物理演算によって自動で行うといった技術です。これまでは何度も繰り返しの手作業で作られていたこうしたアートシェイプを瞬時に完成させてしまうデモは圧巻でした。

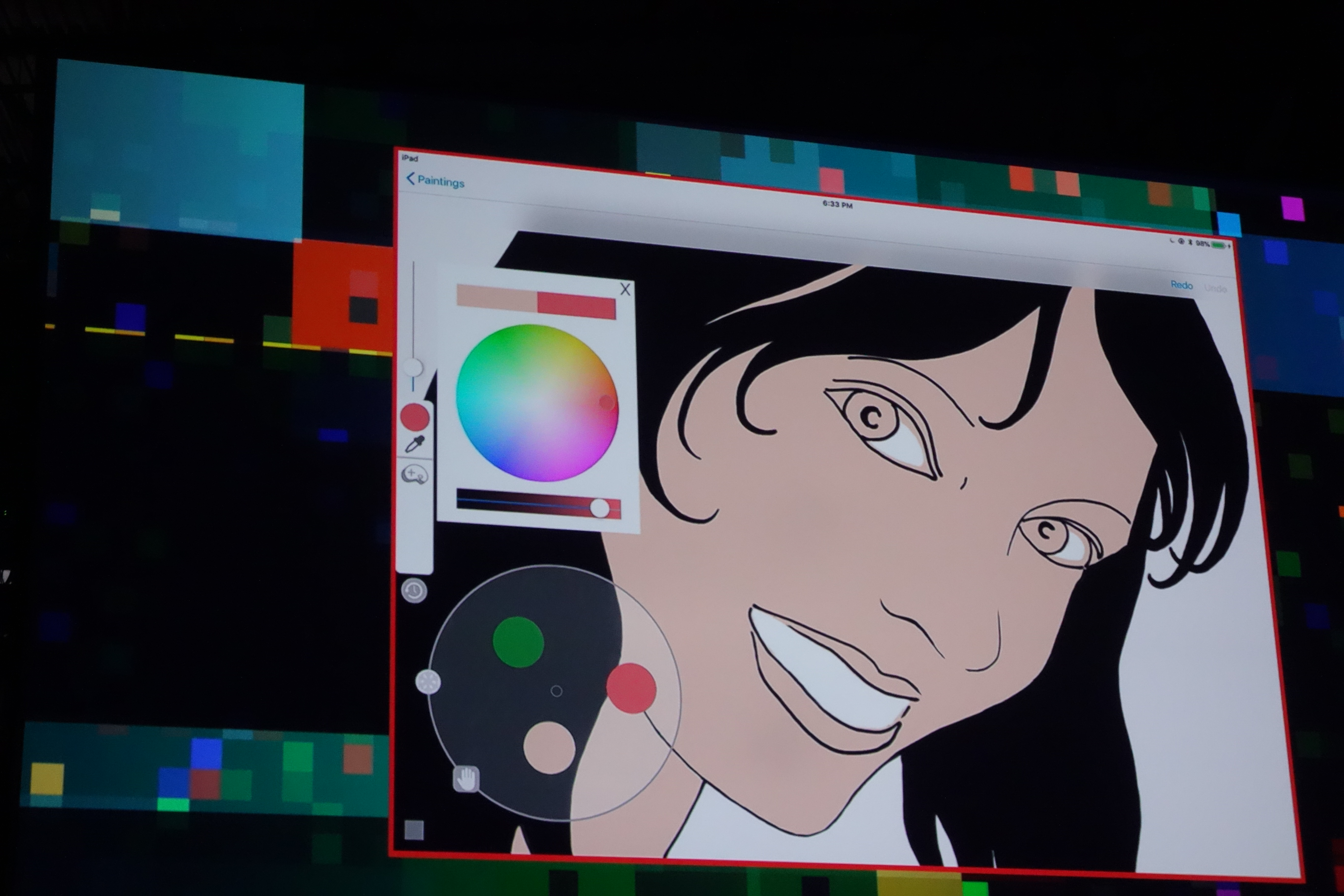

4.#Playfulpalette

まるでアナログの油絵や化粧品のパレットのように色を混ぜ合わせて使えるカラーパレットの紹介です。

選択した色から合成されるこのパレットは、生み出した色を別途保存したり、後から一部の色を変更したりすることができ、まさにアナログとデジタルの良いところを凝縮したアイデアでした。

5.#SonicScape

360度のVR動画編集が可能になってきた近年、次の課題となるのが360度空間中の音響編集です。SonicScapeでは好きな音をVR空間内の任意の場所に設置することができ、まるでその地点から音が鳴っているかのように映像の中に織り込ませることができます。

写真からでは少しわかりづらいですが、紹介されたデモでは川の上に写り込んでいる鳥の位置に対して鳴き声のSEファイルを設置しました。すると本当にそこから鳥が鳴いているかのような音響が再現されます(正面や背面など自分の位置に合わせて音の強弱や反響がシュミレートされるといった具合です)。

6.#Sidewinder

360度のVR動画といっても、見渡せるのは撮影が行われた一地点を基準とした範囲だけです。

Oculusなどでは別途ハードウェアを追加することによってユーザの位置検出を行うことが可能ですが、Sidewinderはソフトウェア処理だけでVR映像の中で、物体の回り込みや視線高さの上下を実現しました。撮影された映像から深度を計測し、空間にどのようなものがあるかを推測しているそうです。

こちらもAdobe Senseiによる大量データからの学習の賜物です。

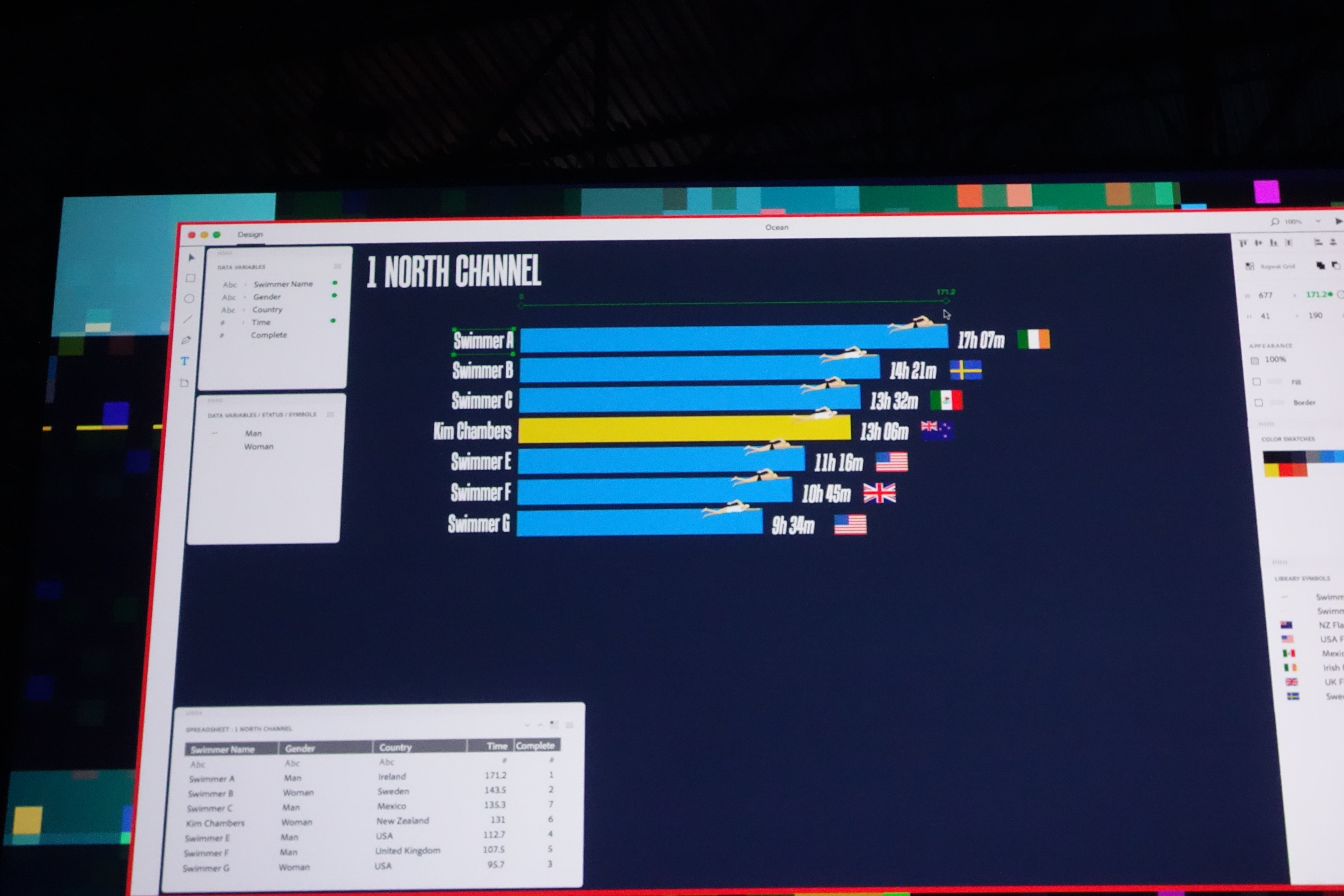

7.#Incoln

Incolnは情報可視化のためのツールです。これまでの情報可視化といえば、データがありそこからグラフや表を描いていましたがIncolnはその逆を行きました。

任意の絵を描いてからそれに対応するデータを紐づけると、自動で絵の長さや色などのレイアウトを調整します。

デモでは水色の矩形と水泳選手のアイコン等を設置した後に競泳大会のデータを紐づけることによって、あっという間に競技結果の可視化を行なっていました。

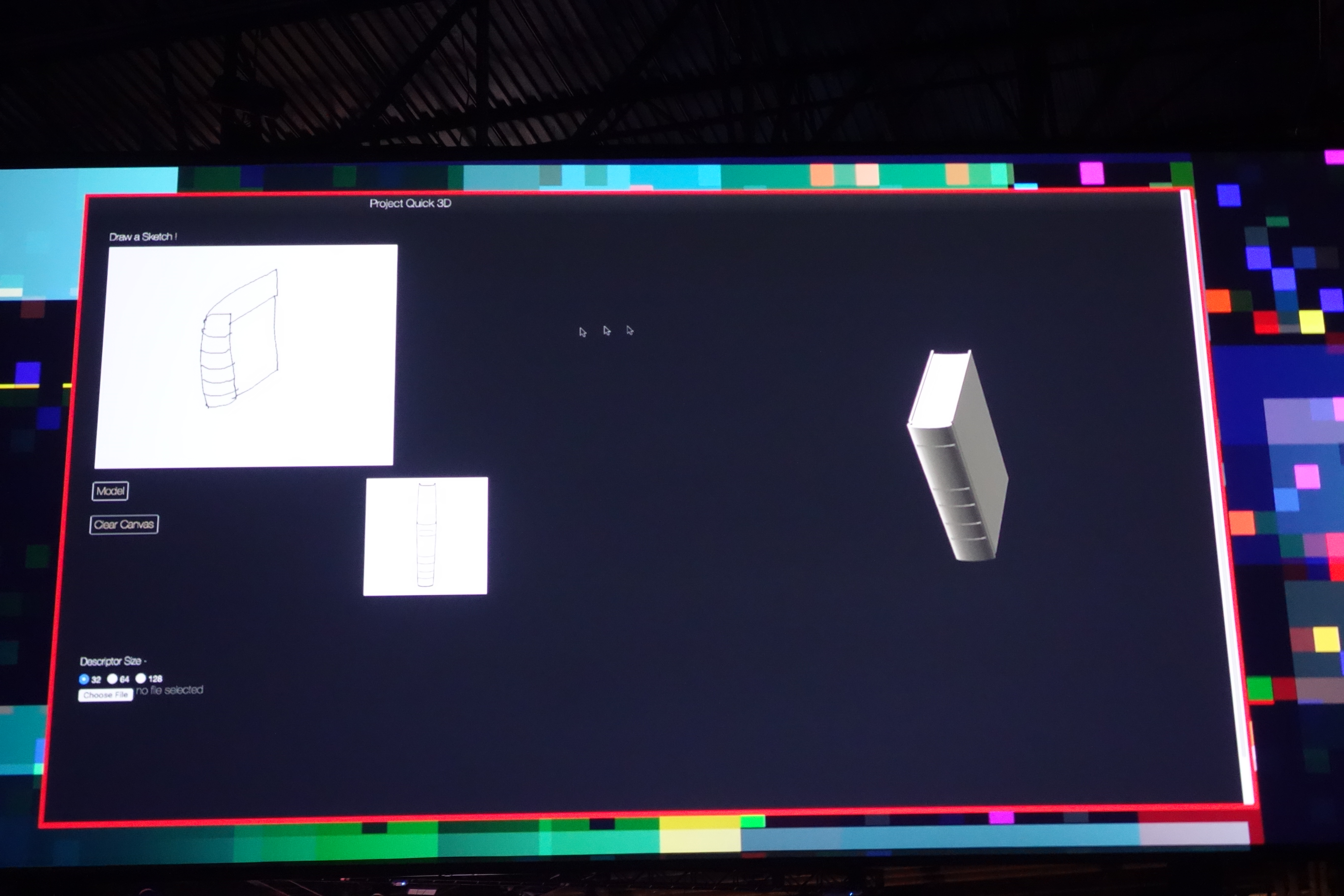

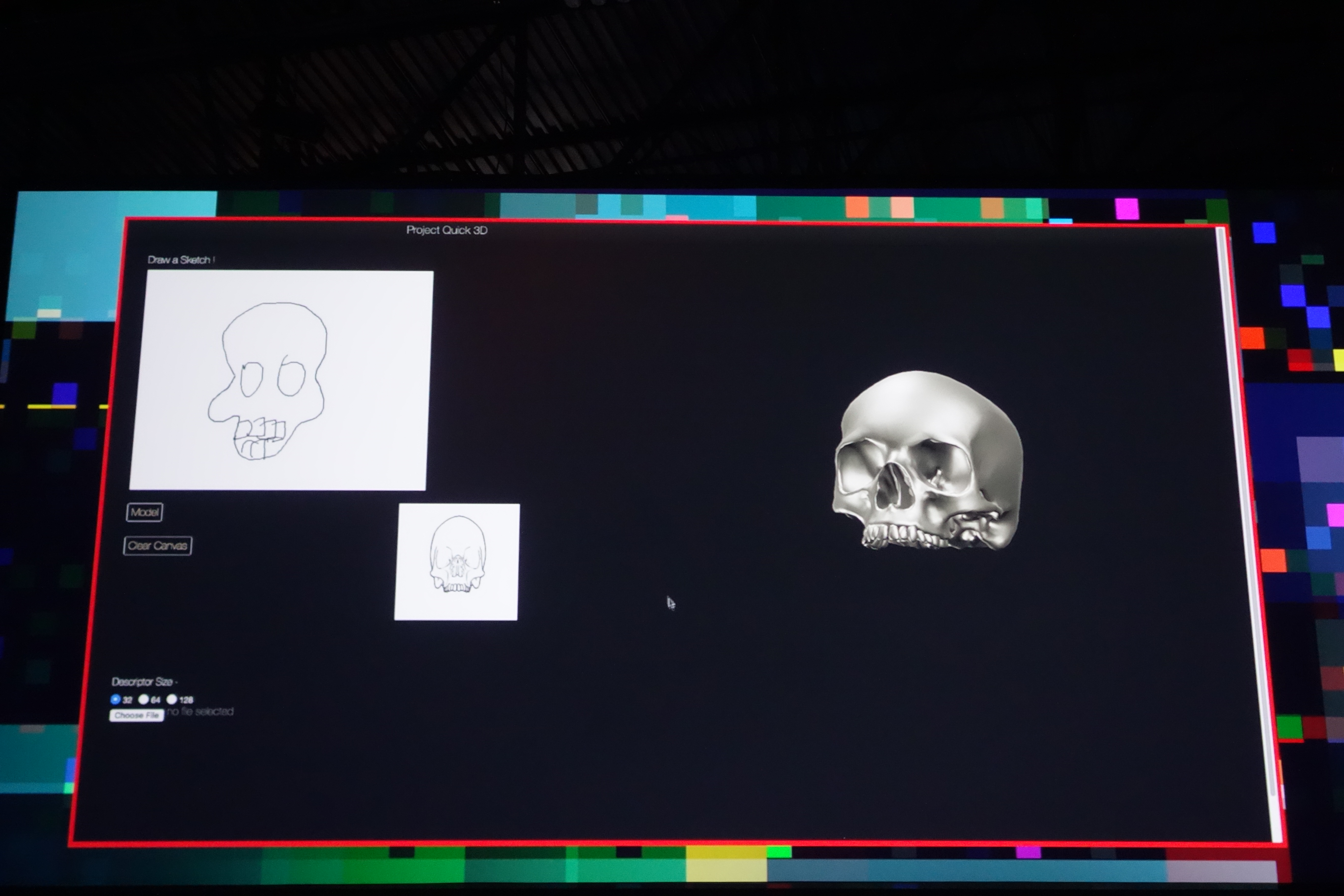

8.#Quick3d

Quick3dは非常に直感的かつ分かりやすい技術です。ラフに描いたスケッチから3Dモデルを再現!

とは言っても、流石にその場でモデリングが行われているわけではありません。描かれたスケッチに対して、まずはAdobe Stockの中から類似した2Dのイラストを検索。その2Dイラストを元に、さらにAdobe Stockの中から3Dデータを引っ張ってくるといった仕組みです。

仕組み自体は単純なものですが、Adobe Senseiの学習機能によるラフスケッチに描かれたものの特定と、Adobe Stockに蓄積された膨大な3Dデータがあるからこそなし得る技と言えます。

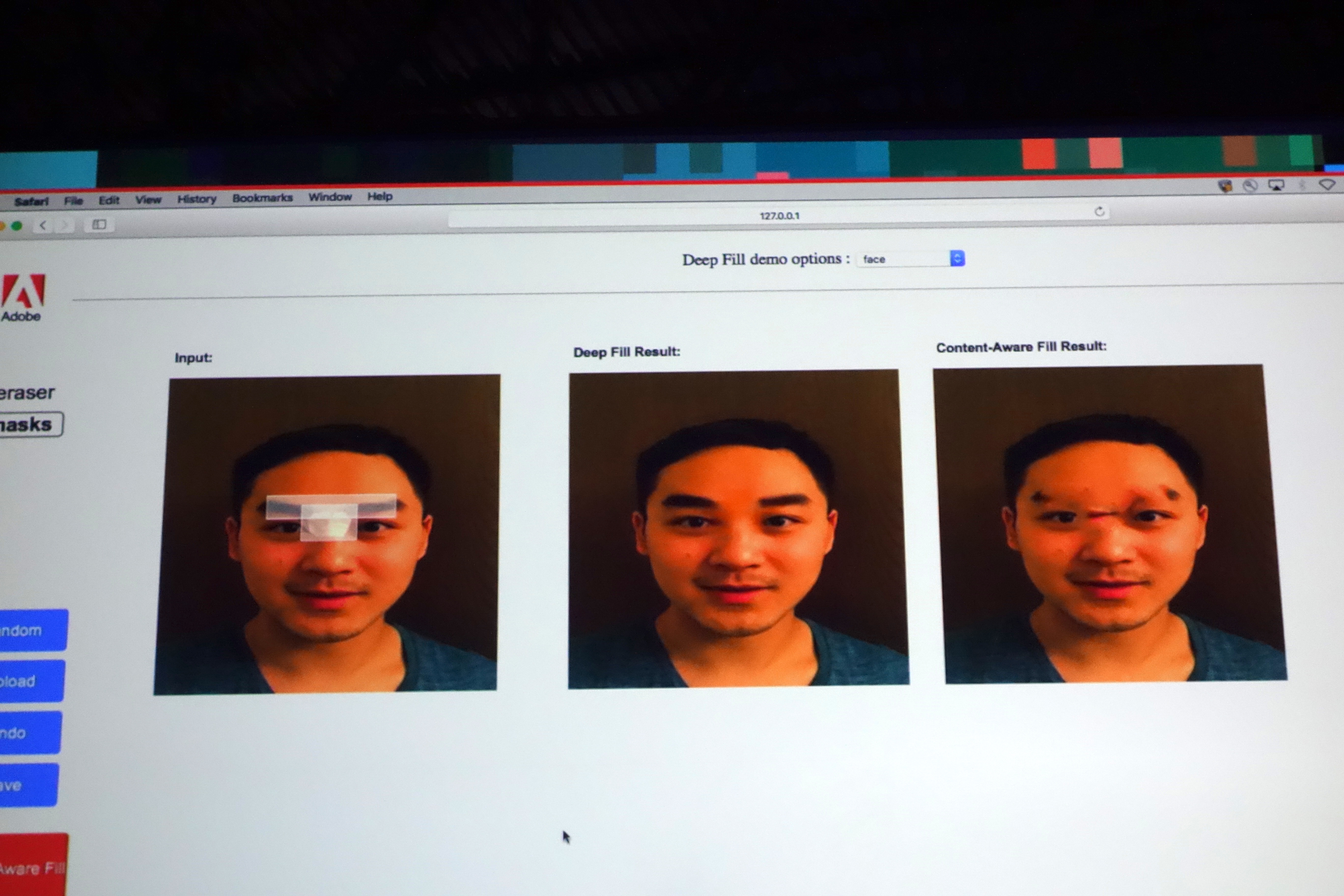

9.#DeepFill

DeepFillはPhotoshopのContent-Awareを進化させた機能です。

2つ目に紹介したScencestichに似た技術ですが、こちらは写真になにが写っているのか(画像の例ですと「人の顔」)を認識した上で最適な結果の合成を行います。画像中央の顔写真がDeepFillによる合成ですが、右のContent-Awareによる結果と比べると差は歴然としていますね。

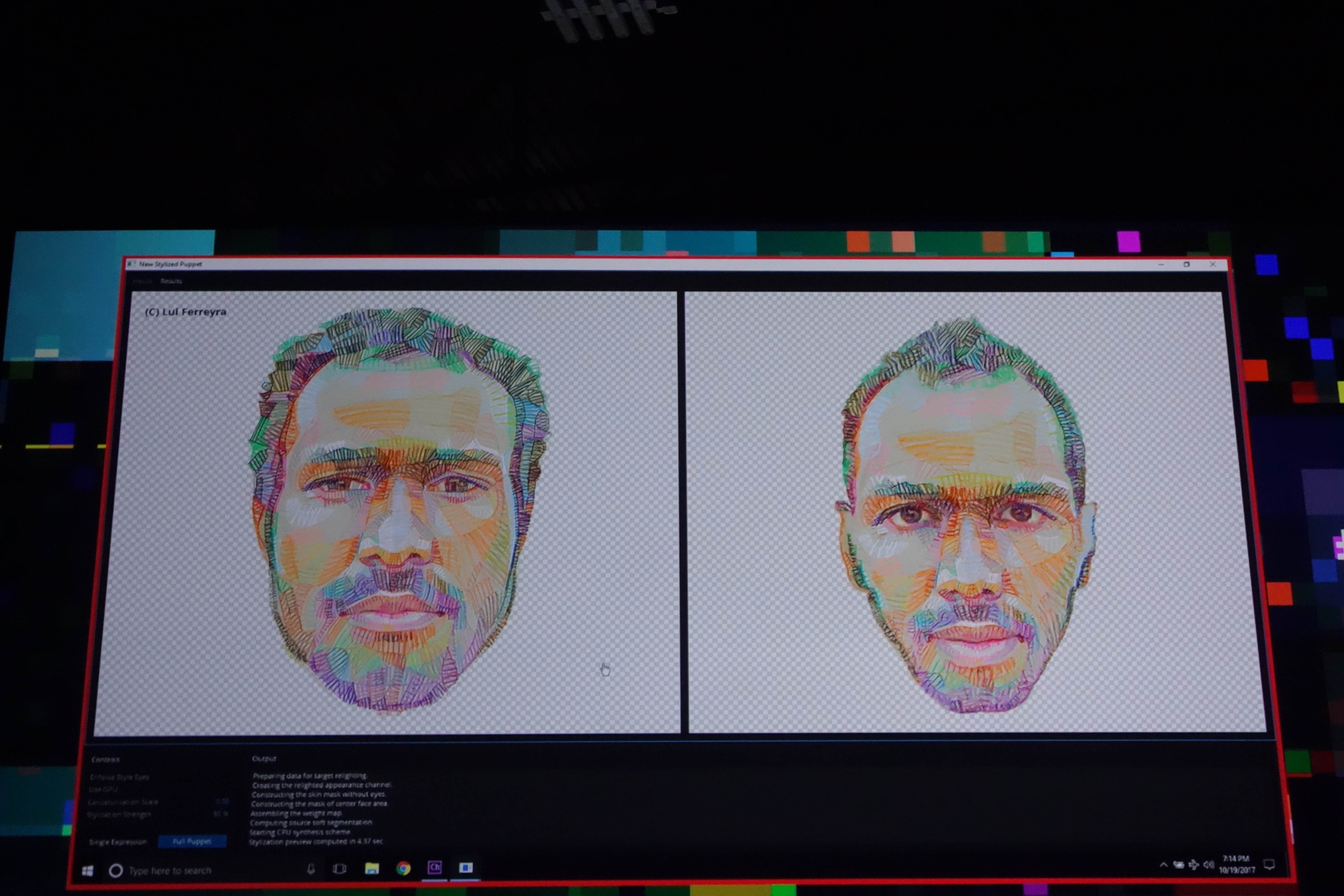

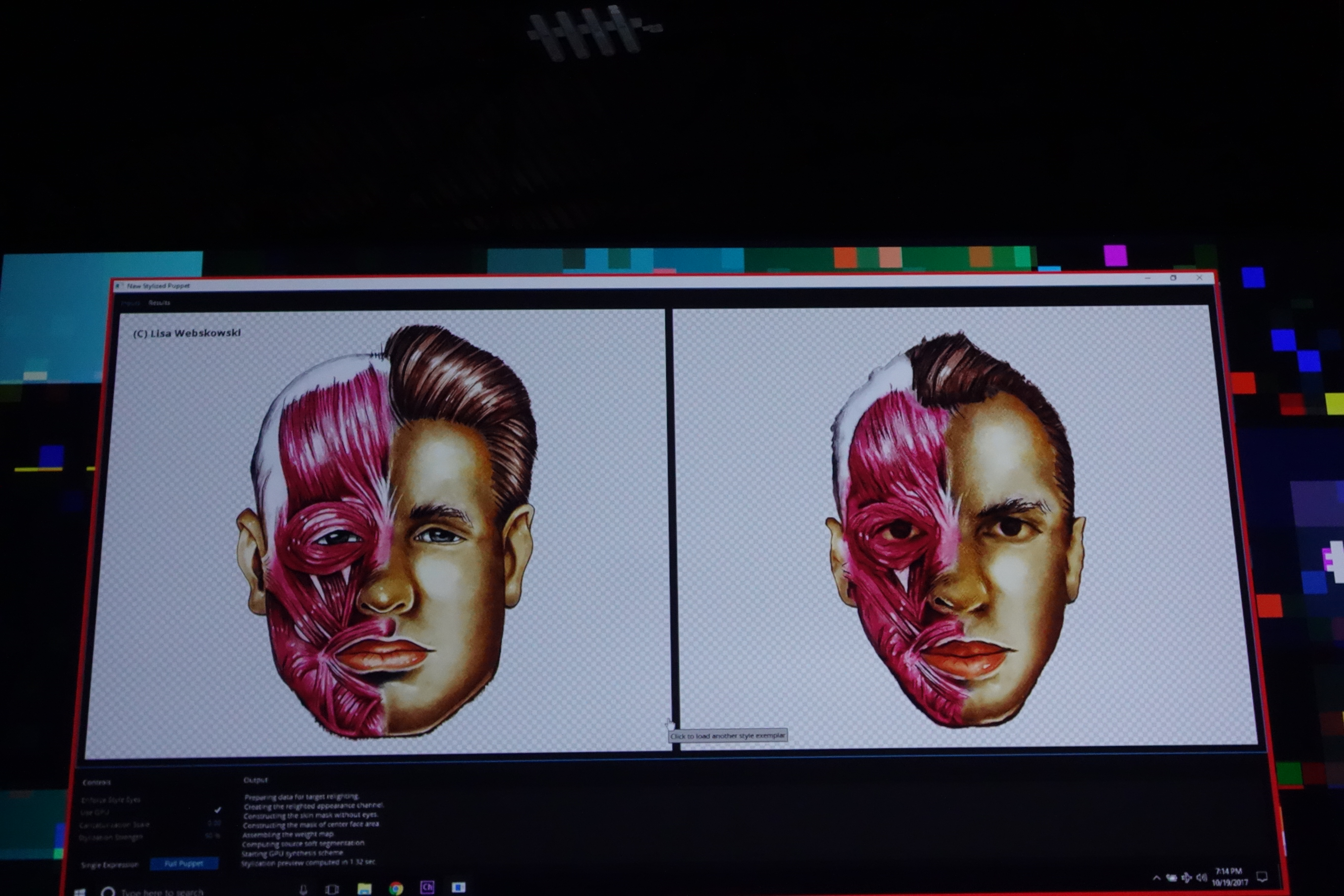

10.#Puppertron

自分の顔写真に好きなタッチのイラストを合成することができる技術です。

スクリーン左側がイラスト素材、右側が合成結果ですが、色調やタッチが揃うだけではなく、人体模型のようなテイストまで再現できてしまうのはとてつもないですね。

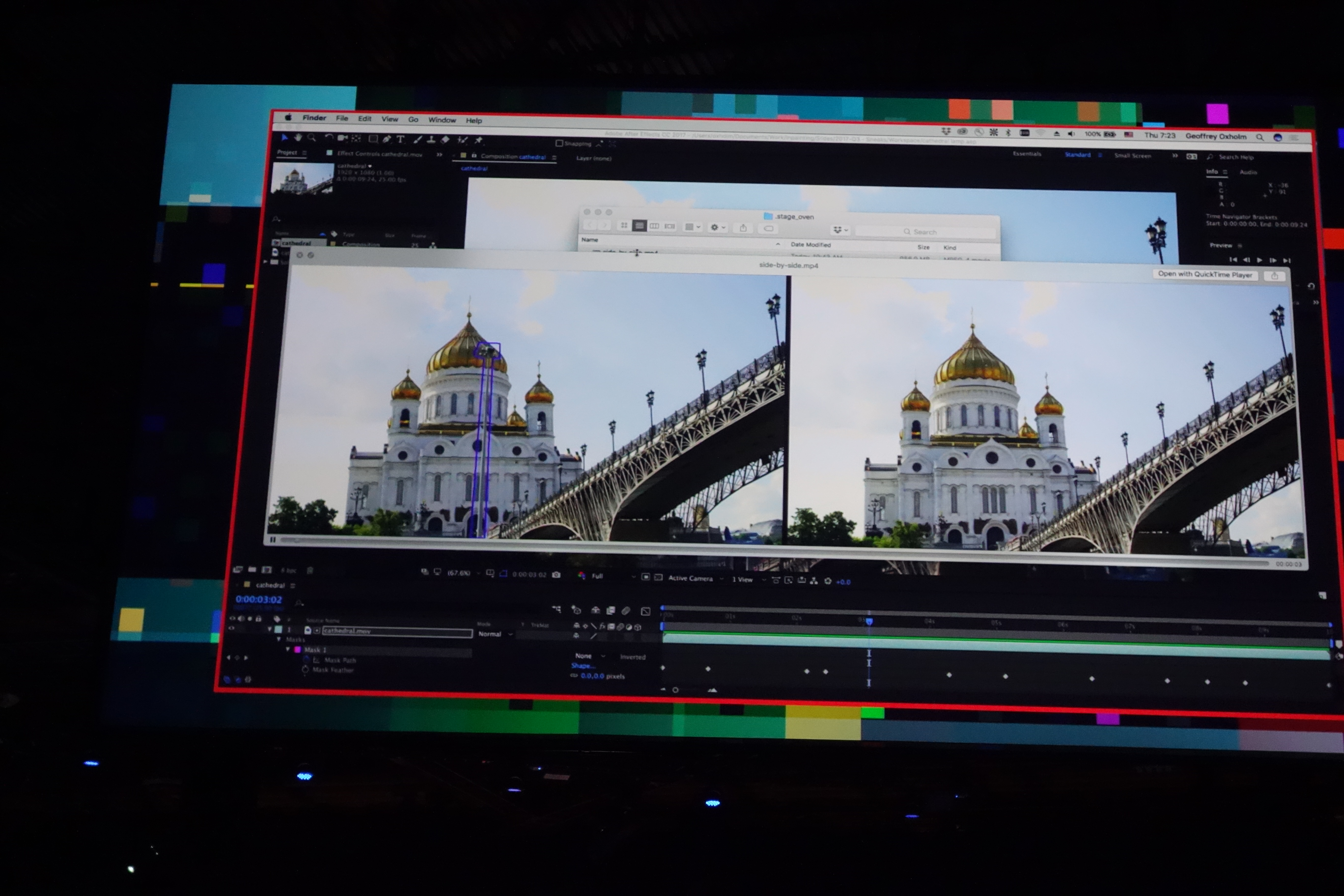

11.#Cloak

最後に登場したのは映像中の物体を綺麗に削除してしまうトンデモ技術。

これまでは動画の毎フレームの画像に対してContent-Awareのような処理を施す必要がありましたが、その場合映像として再びつなぎ合わせた際に違和感のあるものになってしまっていたそうです。

そこでその微妙な差分やフレームの前後関係のコンテキストをAdobe Senseiで学習/推測することによって、ほぼ違和感なく映像の中から不要なものを削除することが出来てしまいました。

おわりに

1日目の基調講演に引き続き、Adobe Senseiの力が炸裂した新機能ばかりでした。

紹介された11の機能はどれも非常に魅力的で、デモが成功するたびに会場からは歓声があがっていました。

ここで紹介された技術はまだまだデモ段階であり、製品に搭載されるかどうかは未確定なものですが、昨年のSneaksで紹介されたリアルタイムVR編集機能の実装が実現したように、近い将来われわれが気軽に扱える日が来るのかもしれません。