目次

こんにちは釘宮です。ただいまアメリカはマウンテンビューというところにいます。

Google が開催するクリエイティブ・カンファレンス『Google IO 2016』が日本時間5月19日に開催されました。このイベントは全世界から7000人以上が参加する3日間の大規模なイベントとなっています。初日は基調講演としてGoogleの新たなサービスやプロダクトに関する発表がされました。

今回は現地に渡った @kgmyshin と @wangxuan の二人が速報レポートとしてお伝えします。

Google I/O 2016 基調講演ダイジェスト

- Google Assistantという概念が生まれた

- Google Homeというスマートホームプロダクトが発表された

- Alloという会話をサポートするAIが発表された

- Duoというプレビューから相手が見えるビデオ電話が発表された

- Android Nの新機能の説明について

- daydreamというモバイル用VRプラットフォームが発表された

- Android wearの2.0を発表。スマートフォンがいらなくなる?

- Android Studio2.2を発表。ビルドがより早く

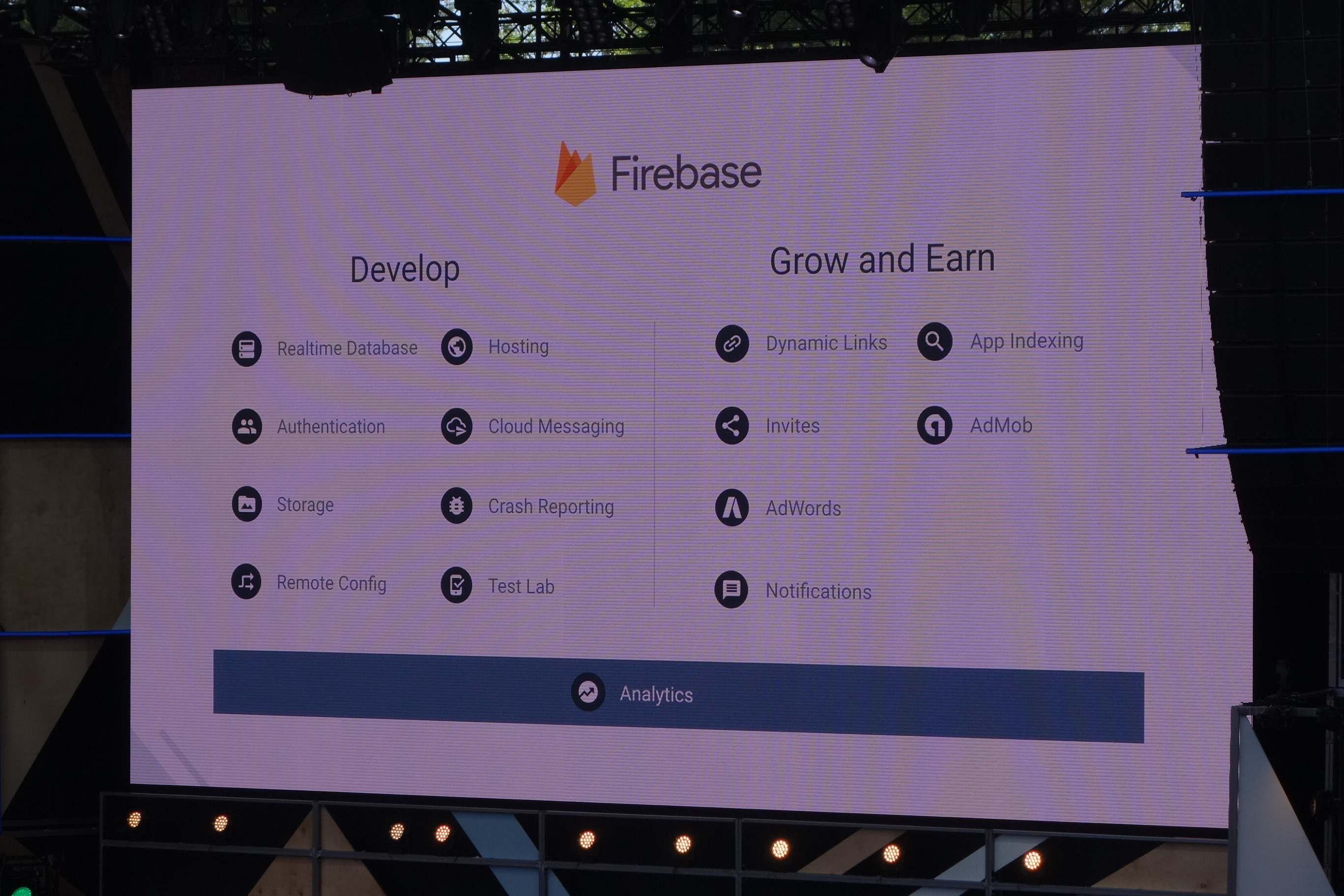

- Firebaseが無制限で無料。Android, iOS, Webすべてサポート

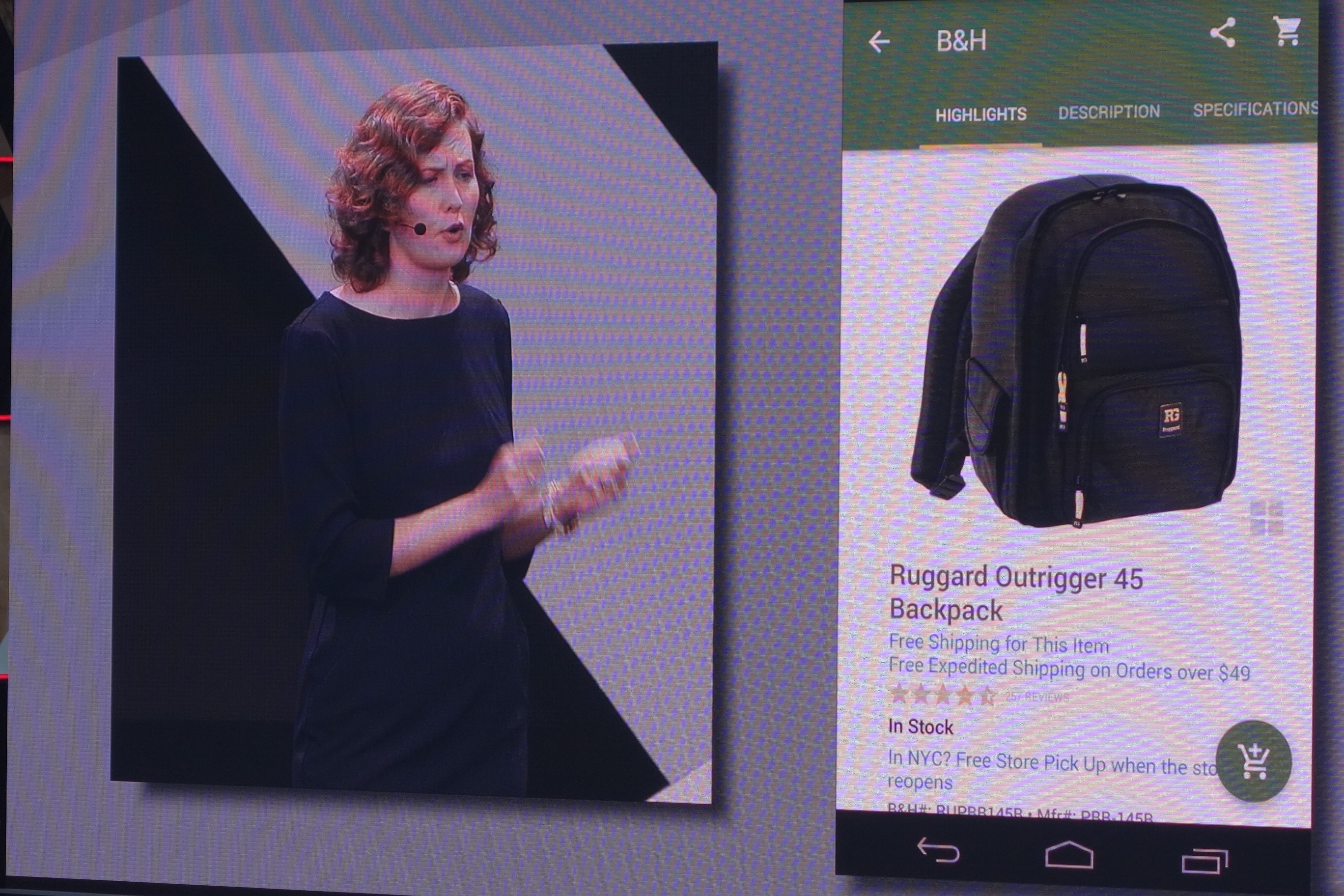

- インストールしなくてもワンタップで機能を使えるAndroid Instant Apps

冒頭では CEO からGoogle Assistant が発表された

オープニングライブが終了するとCEO のSundar Pichai ( サンダー・ピチャイ ) 氏が登場。Google のこれまでのテクノロジーの歩みについて語りました。

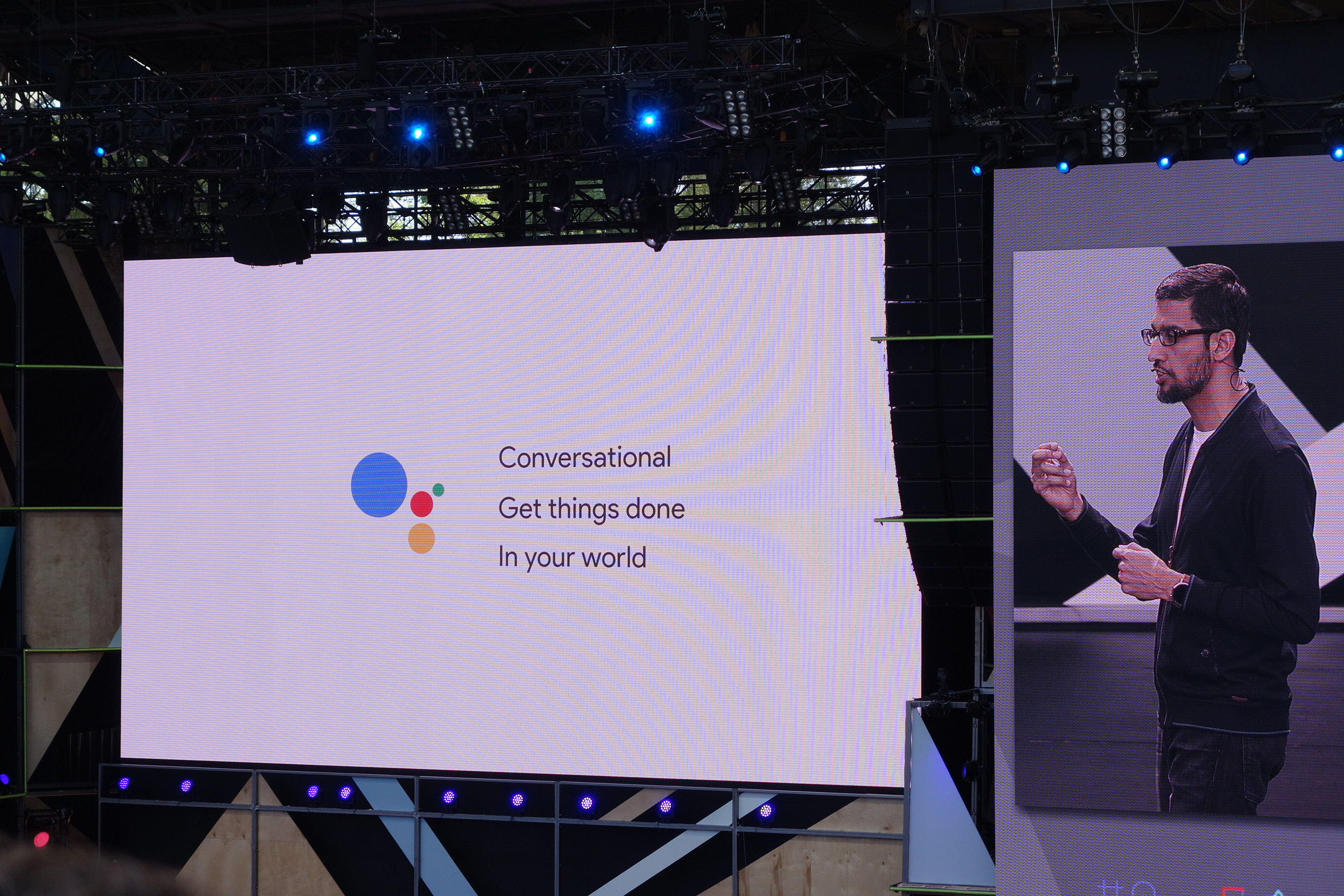

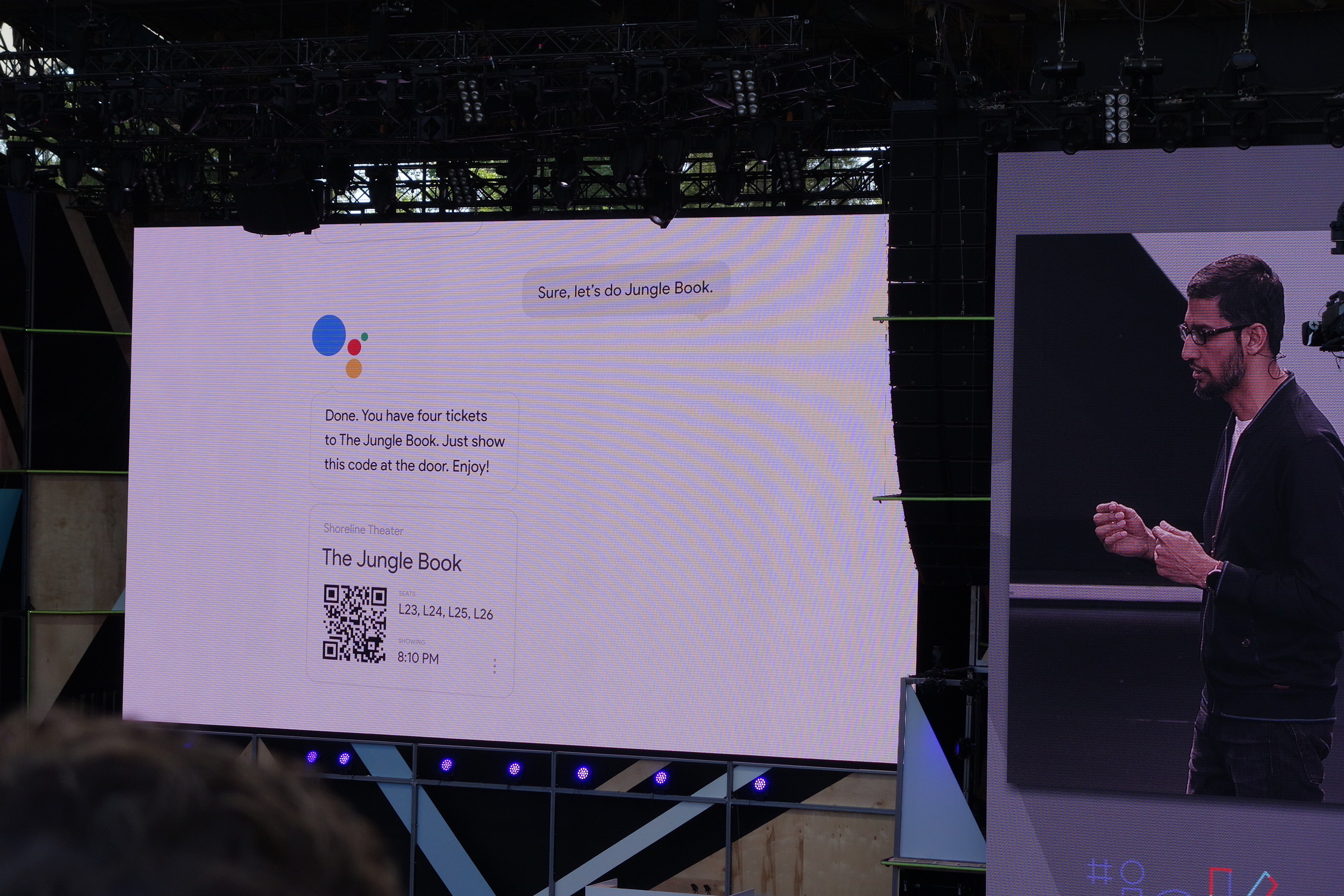

Google はこれまでに大量のありとあらゆるデータを蓄積し、それらを強固な基盤として機械学習および AI の開発に注力してきました。やがてこれらは人々の生活をサポートするようになりました。Google Assistant です。

機械学習とAIによってより人の会話を快適にしてくれるようになりました。

これらを Google Assistantと名付けます。実際のプロダクトがピチャイ氏の発表の後に続きます。

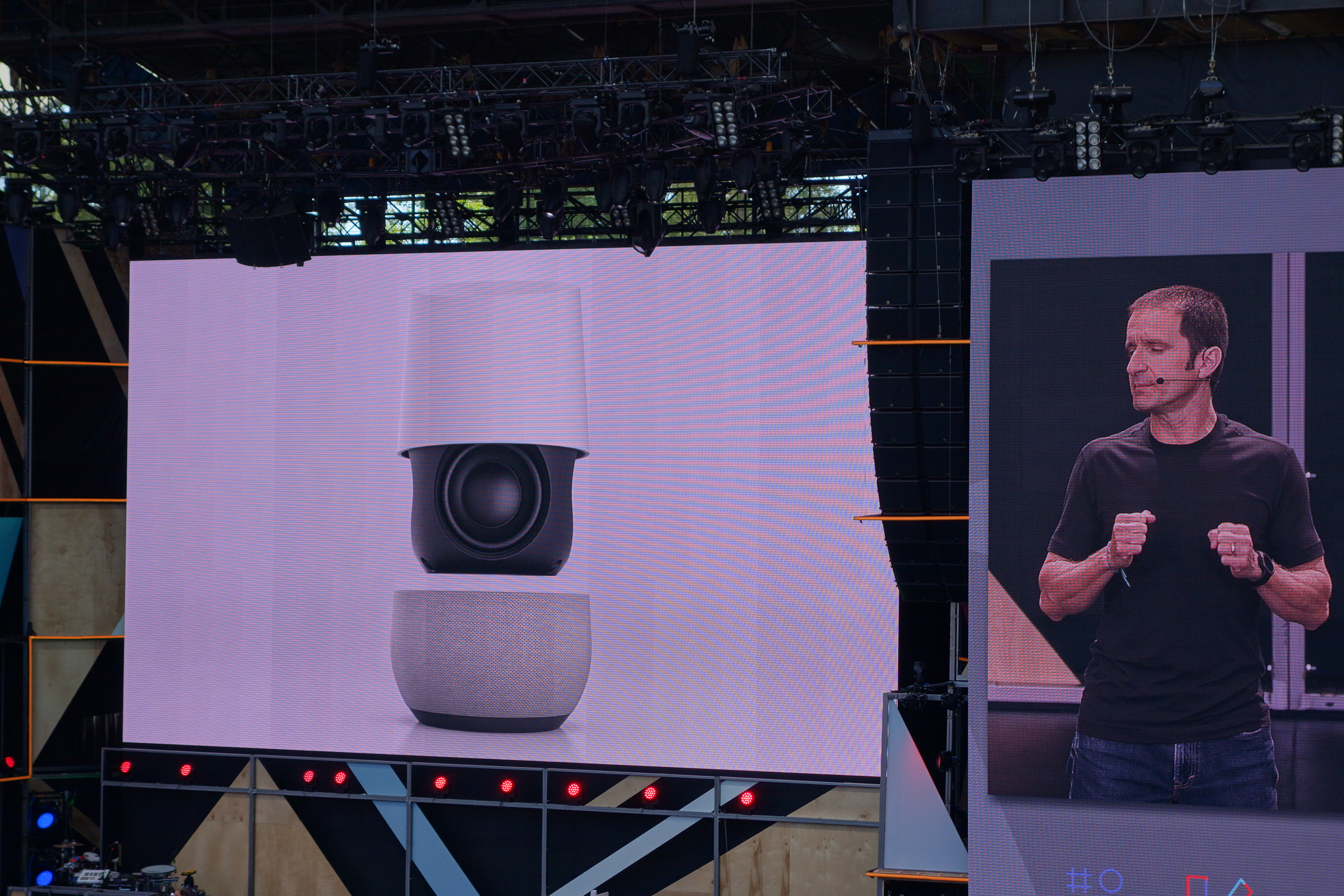

Google Home - 音声だけで完結するスマートホームデバイス

Google Home は 一切手で触れることなく全ての操作を人間の音声だけで完結することができるデバイスです。昨年Amazon から『Echo』という人工知能スピーカー ( ※日本未発売 ) がリリースされましたが、Google からも同様のデバイスが登場しました。

実際のプロダクトがこちら。

主な機能としては以下のとおり。

- Cloudやモバイル端末から取得した音楽・映像・テレビの再生

- タスクの管理

- デバイスに話しかけることで音声検索

今後ますます音声認識に注目が集まりそうです。発売時期については今年の後期らへんとのことです。

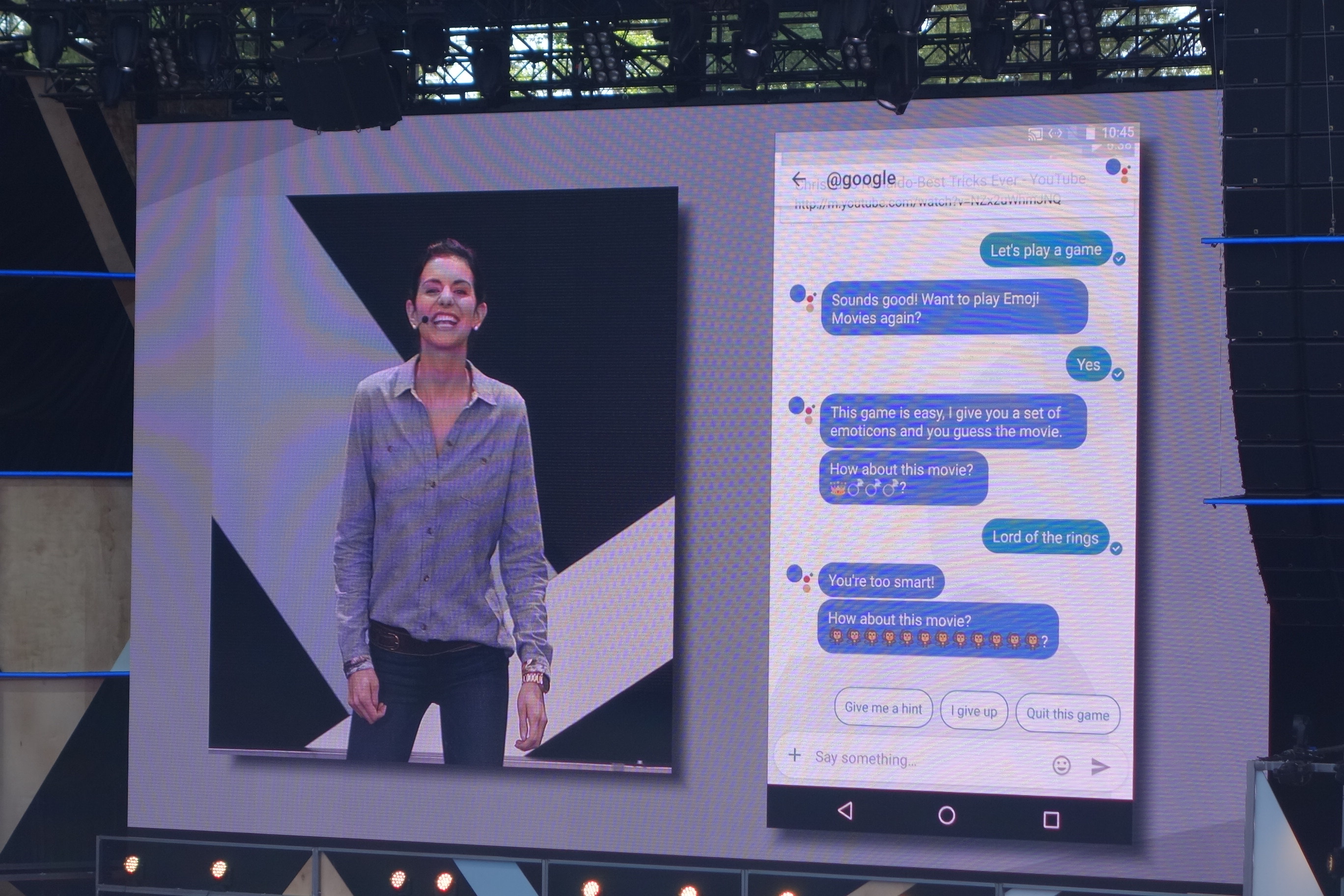

Allo - 機械学習とAIを用いて会話をサポートするメッセージングツール

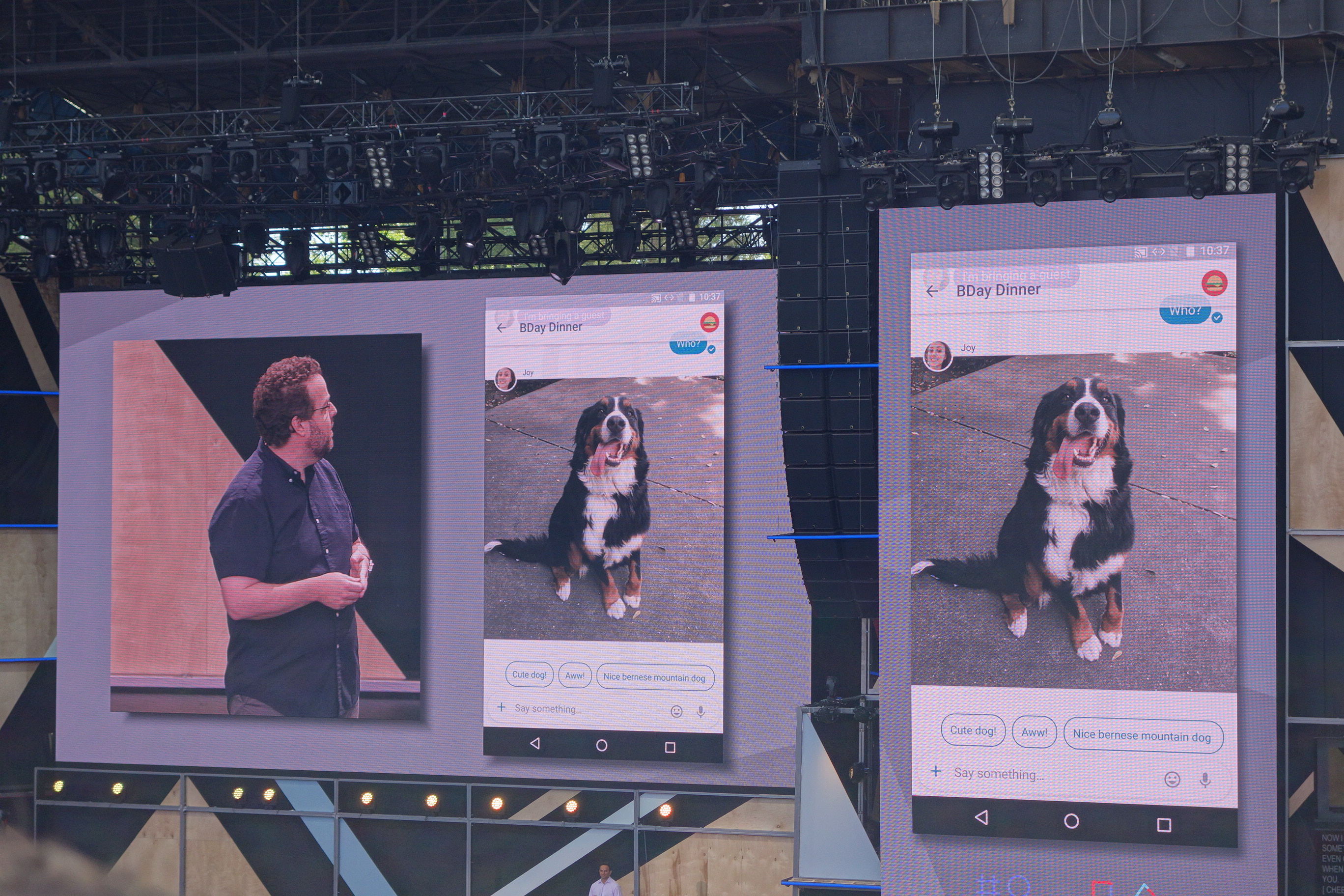

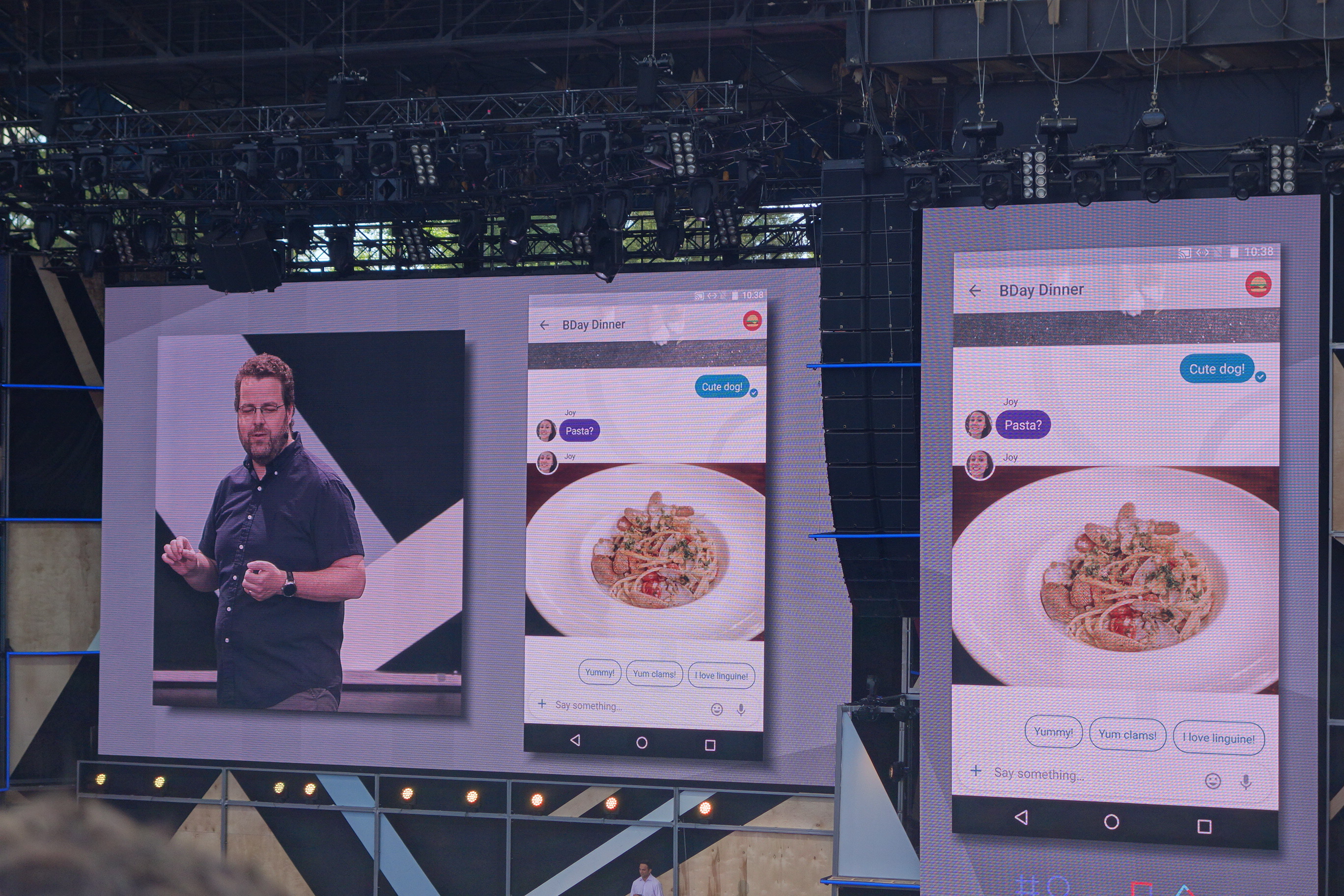

一番大きな機能はスマートサジェスチョン。

例では相手から犬の画像をもらった時の返答として、自動で3つの選択肢を作ってくれています。

こちらの例ではパスタの写真がきて、それに対しての選択肢をまた作成してくれています。

さらに、そのAIとゲームもすることができるようです。

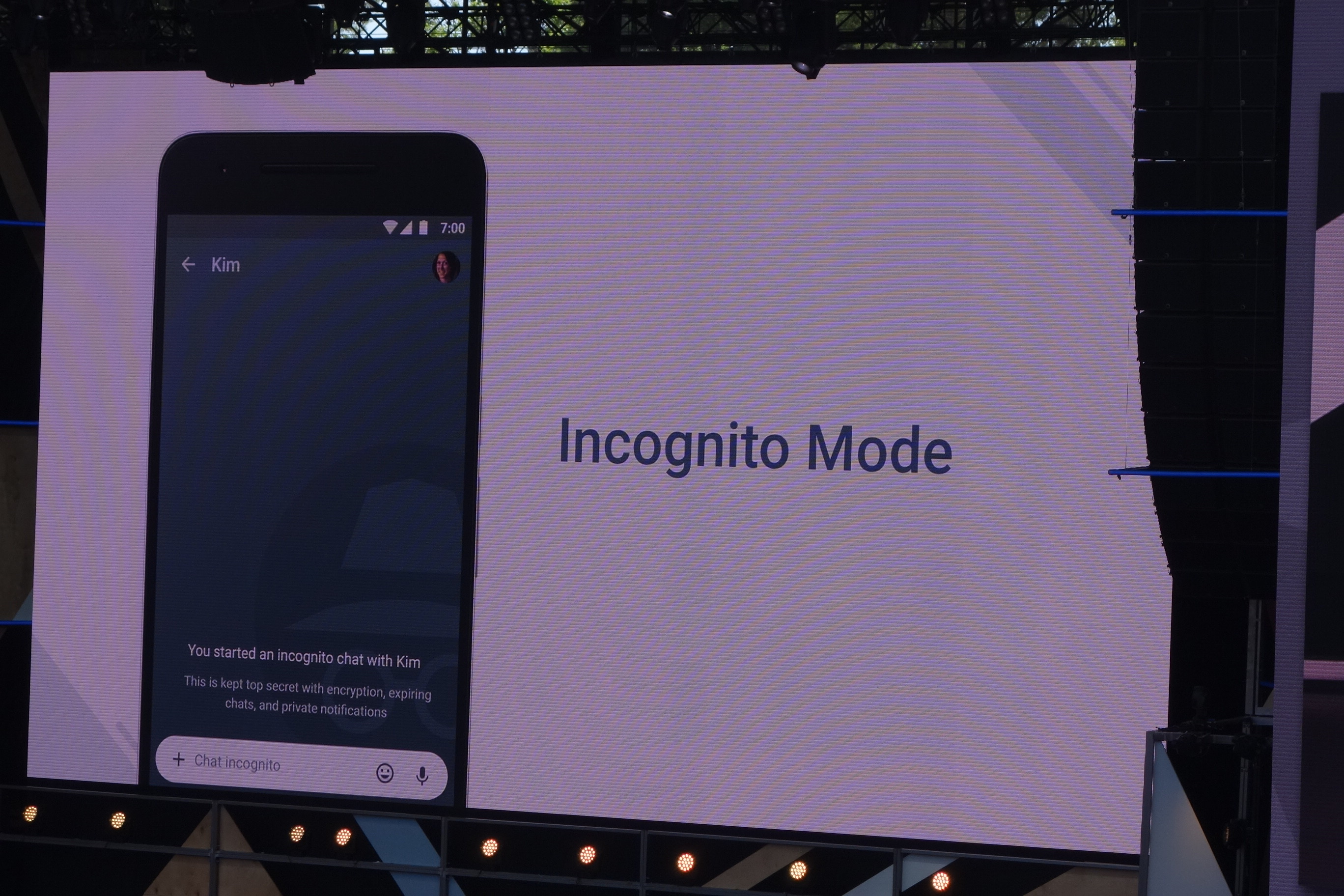

セキュリティの高い Incognite Modeもあるようです。

Duo - プレビューから相手が見えるビデオ電話アプリ

プレビューから相手のビデオを見ることができます。採用されている主なテクノロジーは以下のとおり。

- Web RTC

- Quic

- Seamless Handoff

またiOSとAndroidに対応しており、この夏から使うことが出来るようです。

Android Nの新機能について

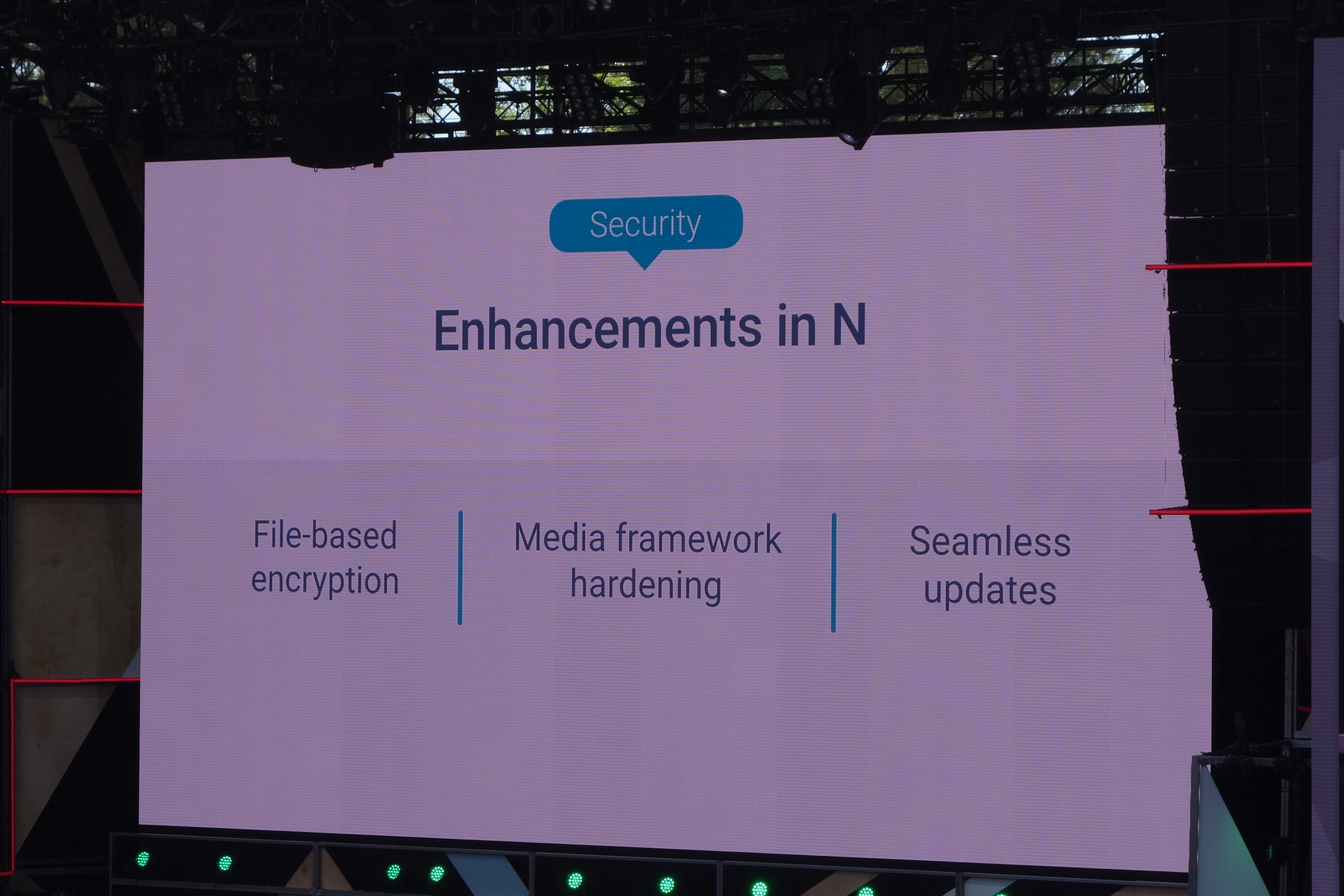

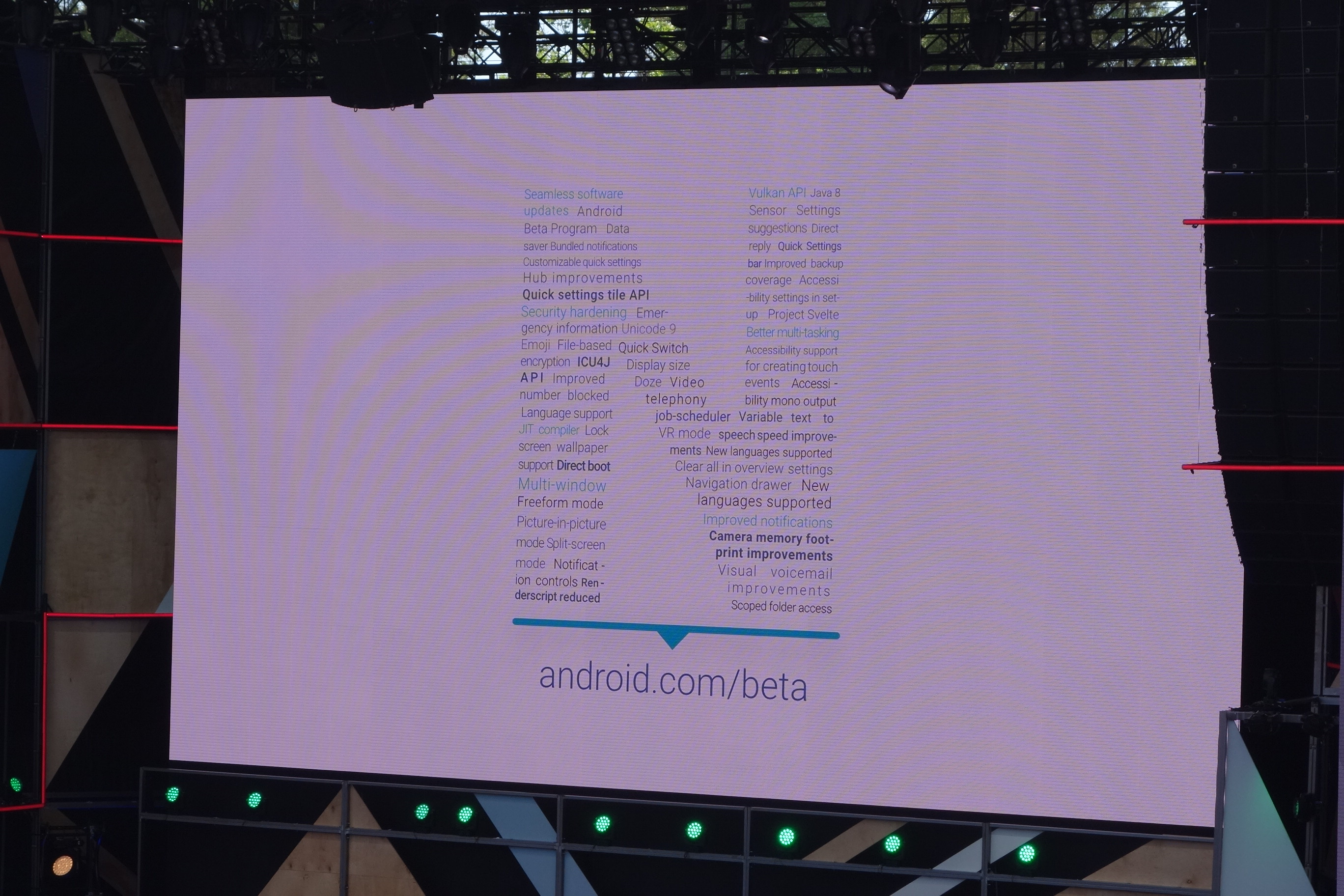

Performance、Security,Productivityという観点で新機能がそれぞれ発表されました。

Performanceの観点からは、3Dグラフィックス API の Vulkan への対応の発表がされました。OpenGL が GPU に対して抽象度の高い API なのに対し、Vulkanはより抽象度を下げた GPU のハードウェア層に近いローレベルな API です。従来の API よりもハードウェアの限界性能を引き出しやすくなっています。同様な API として DirectX12(Microsoft), Metal(iOS), Mantle(AMD) もあります。

デモによっていかに綺麗に描画されているかを示していました。

Securityについて。それぞれ上にあげたようなエンハンスメントを行っているということでした。

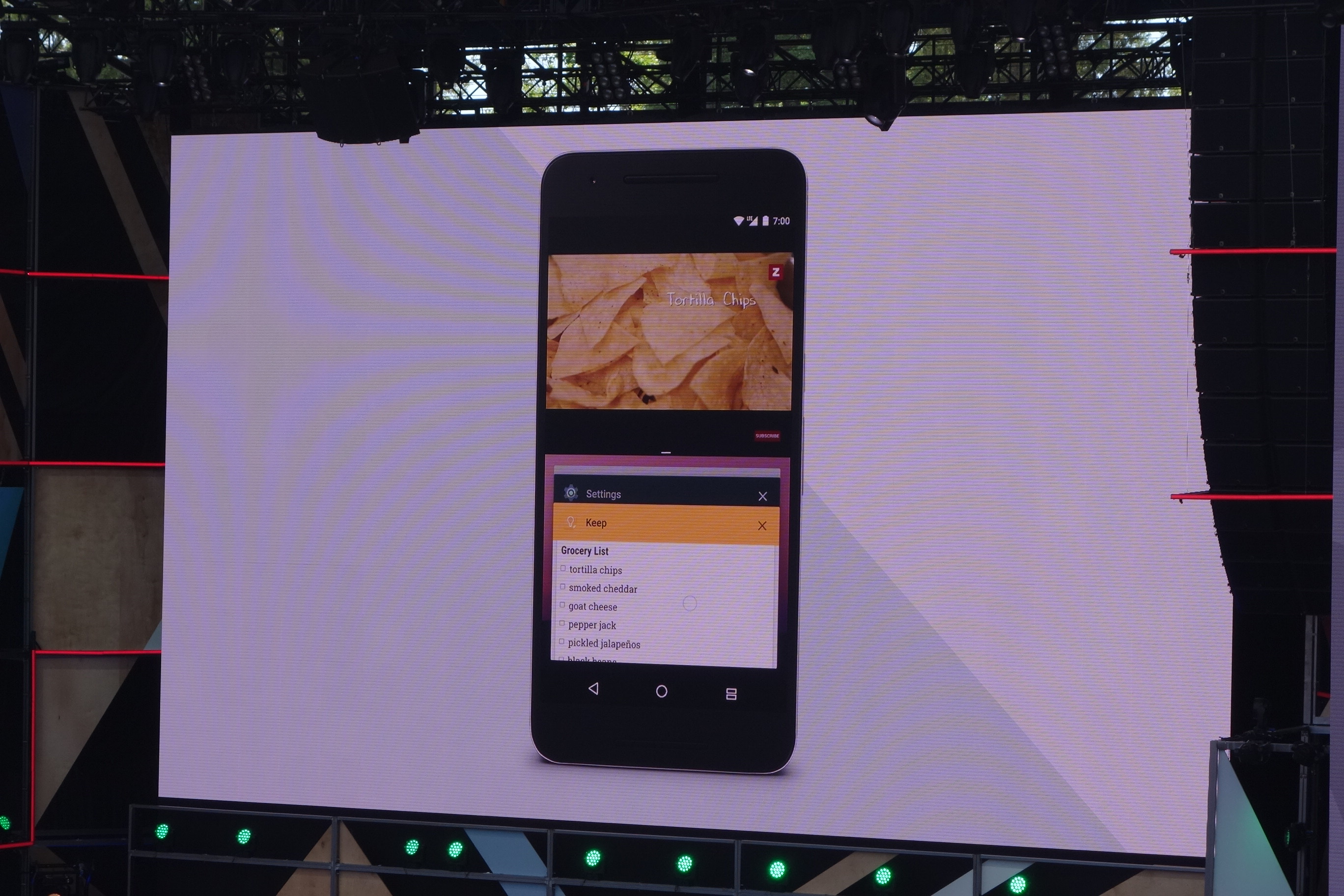

Multi tasking機能の改良によって、タスクをすべてクリアできるようになりました。

次にマルチウィンドウ機能。動画を見ながらショッピングといったことができます。

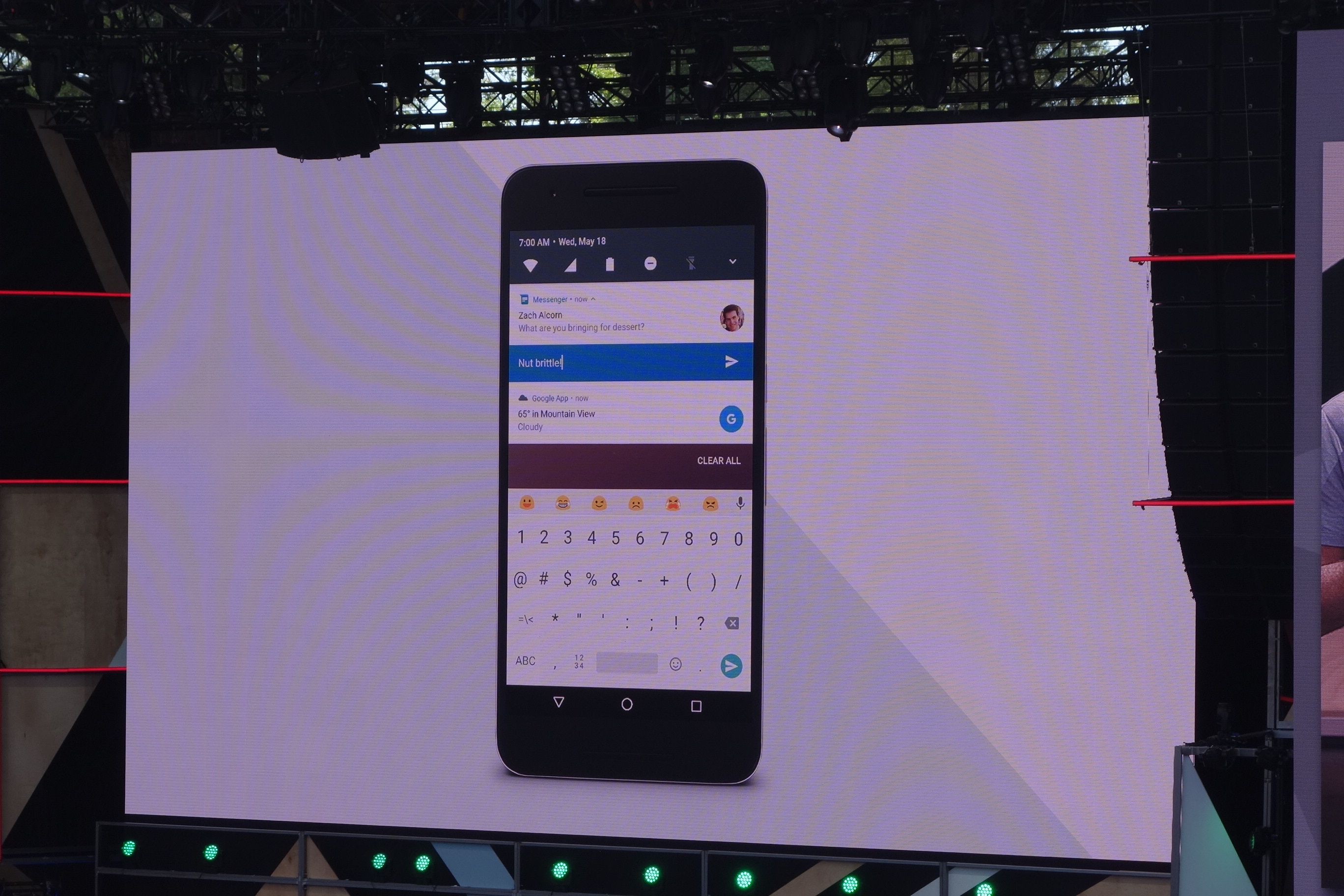

通知がよりリッチになり、通知画面からそのまま返信などができるようになりました。

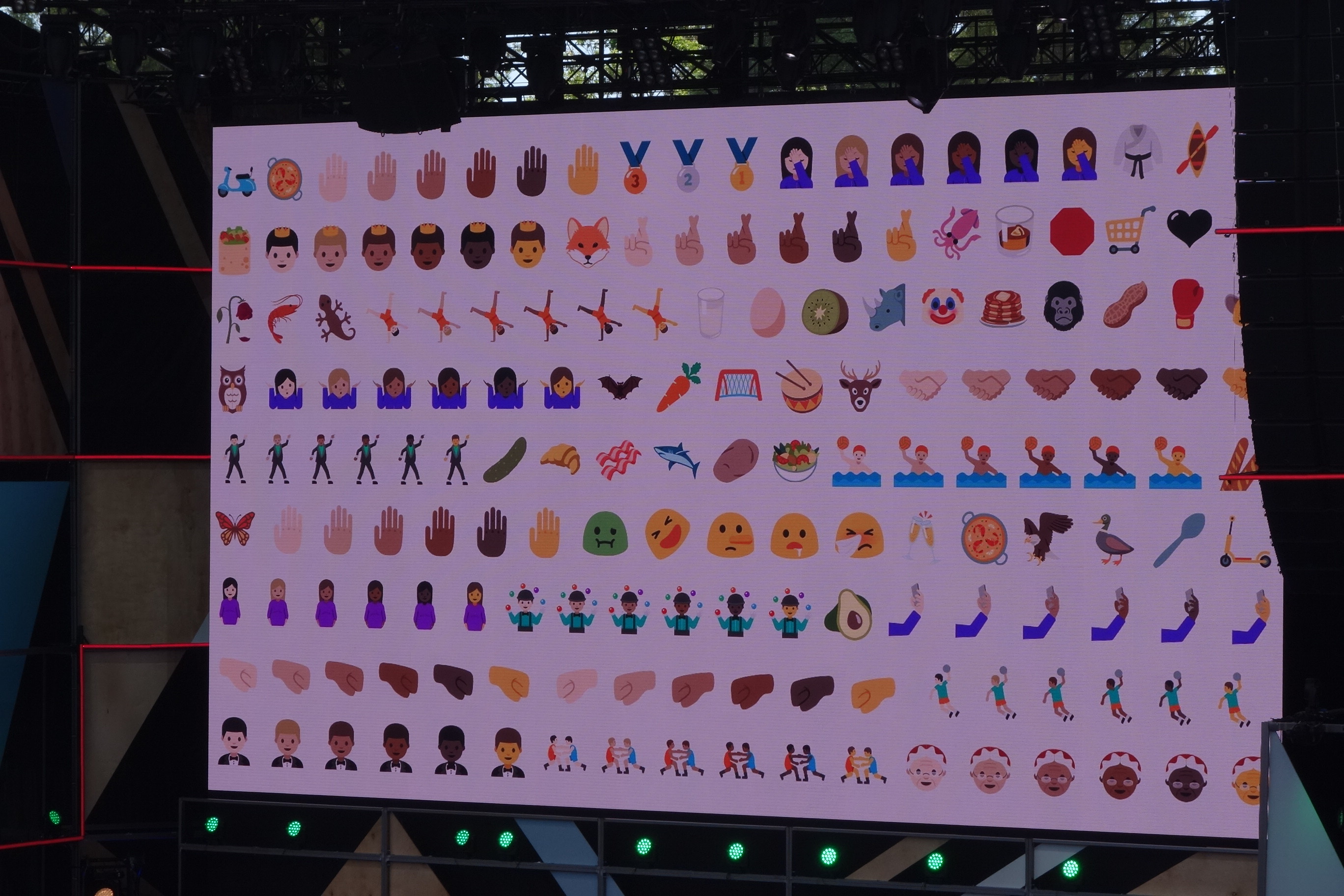

emojiに対応しました。

以上にあげた機能以外にもNでは多くの新機能や改良が行われています。

Daydream - モバイル用VRプラットフォーム

モバイル用VRプラットフォーム Daydreamが発表されました。

すでに対応の準備を進めているベンダー企業がこちら。中国や韓国の企業が目立ちますね。

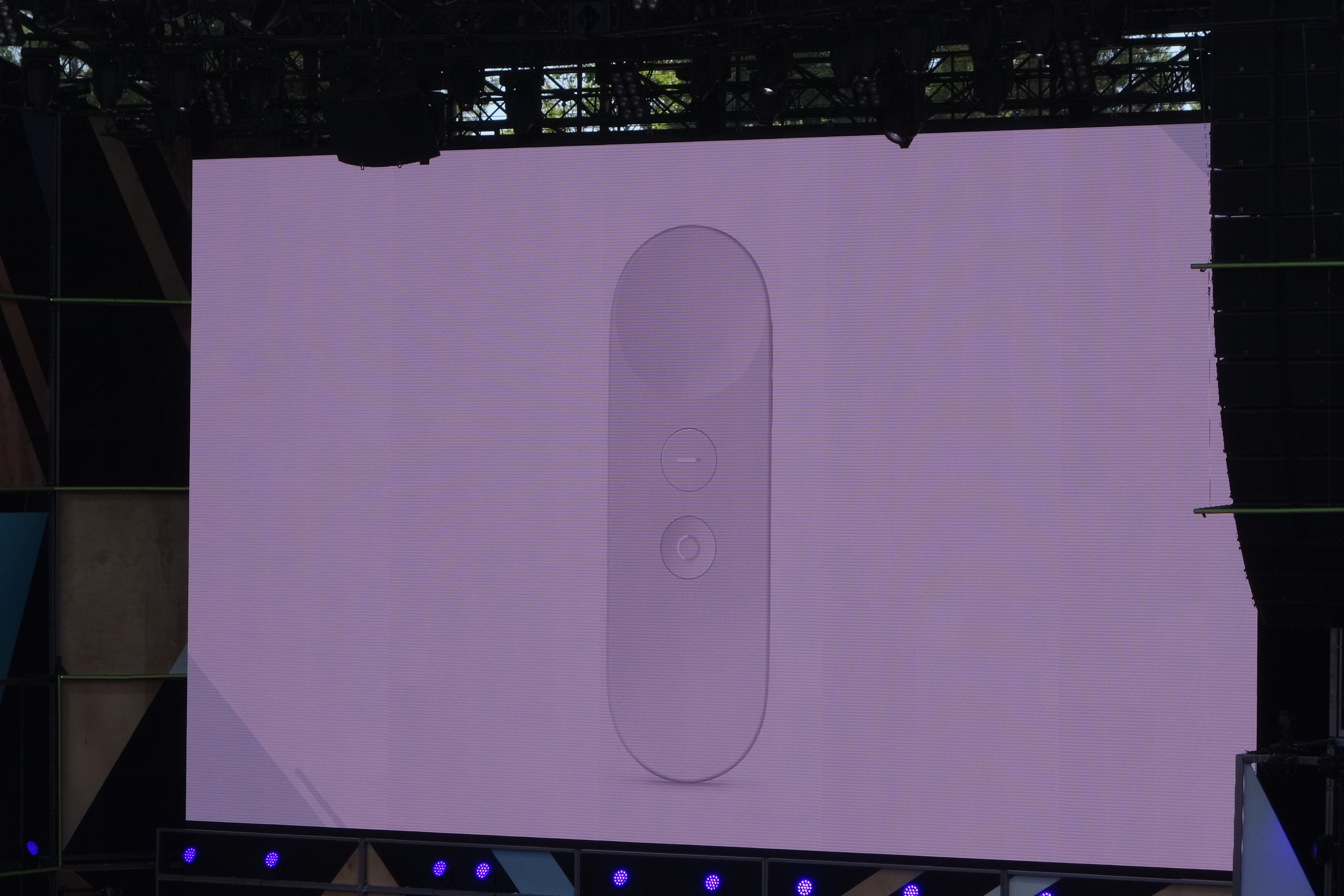

こちらがコントローラー。とてもシンプルなデザインですね。ボタンの類は殆ど無く、内蔵されたセンサーによってほぼすべての動作をカバーすることができます。

すでに数多くの企業がリソースの提供を表明しており、ここでは11の企業名が公開されました。

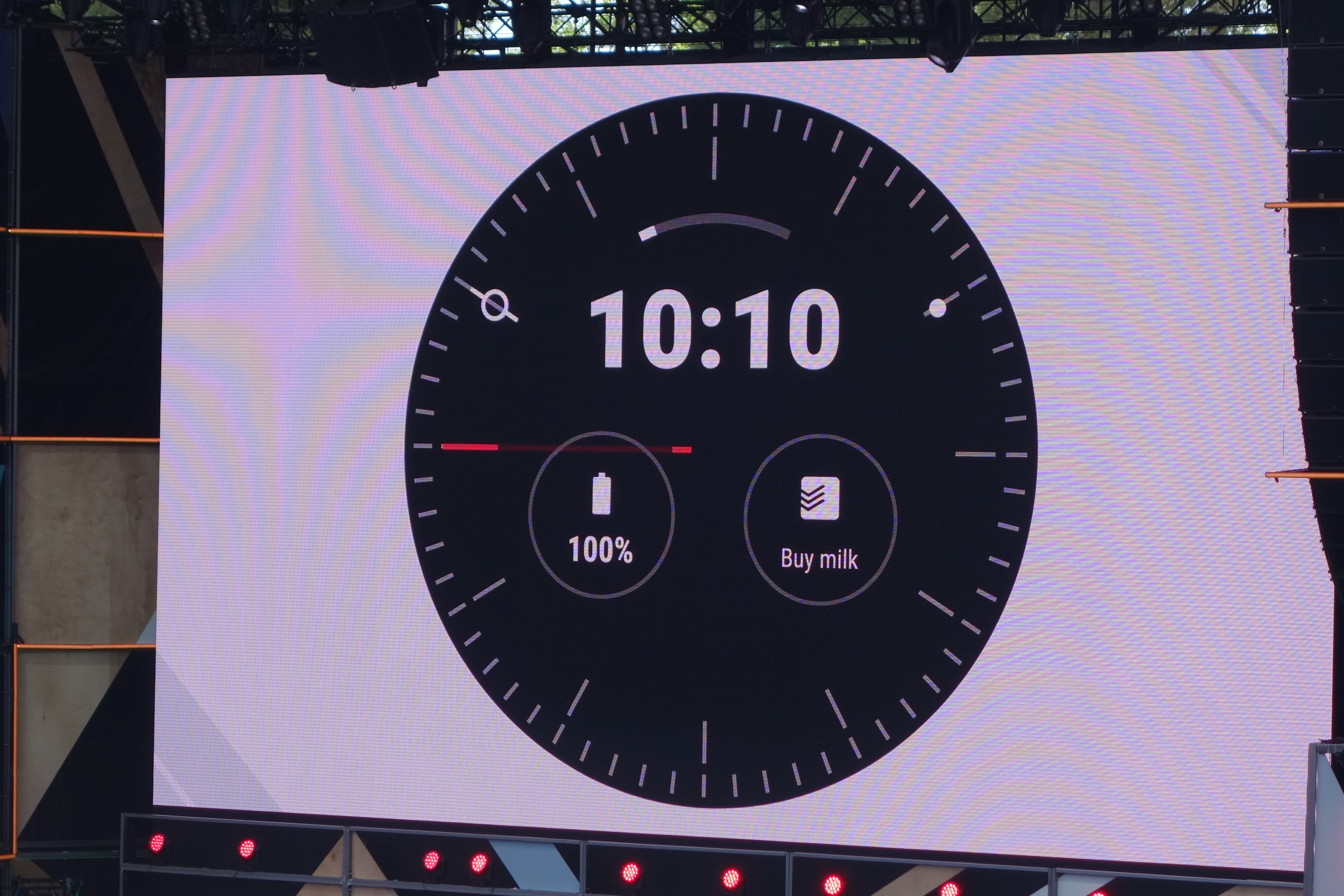

Android Wear 2.0

Android Wear 2.0が発表されました。

まずはウォッチフェースの改善。より良いデザインとなりました。

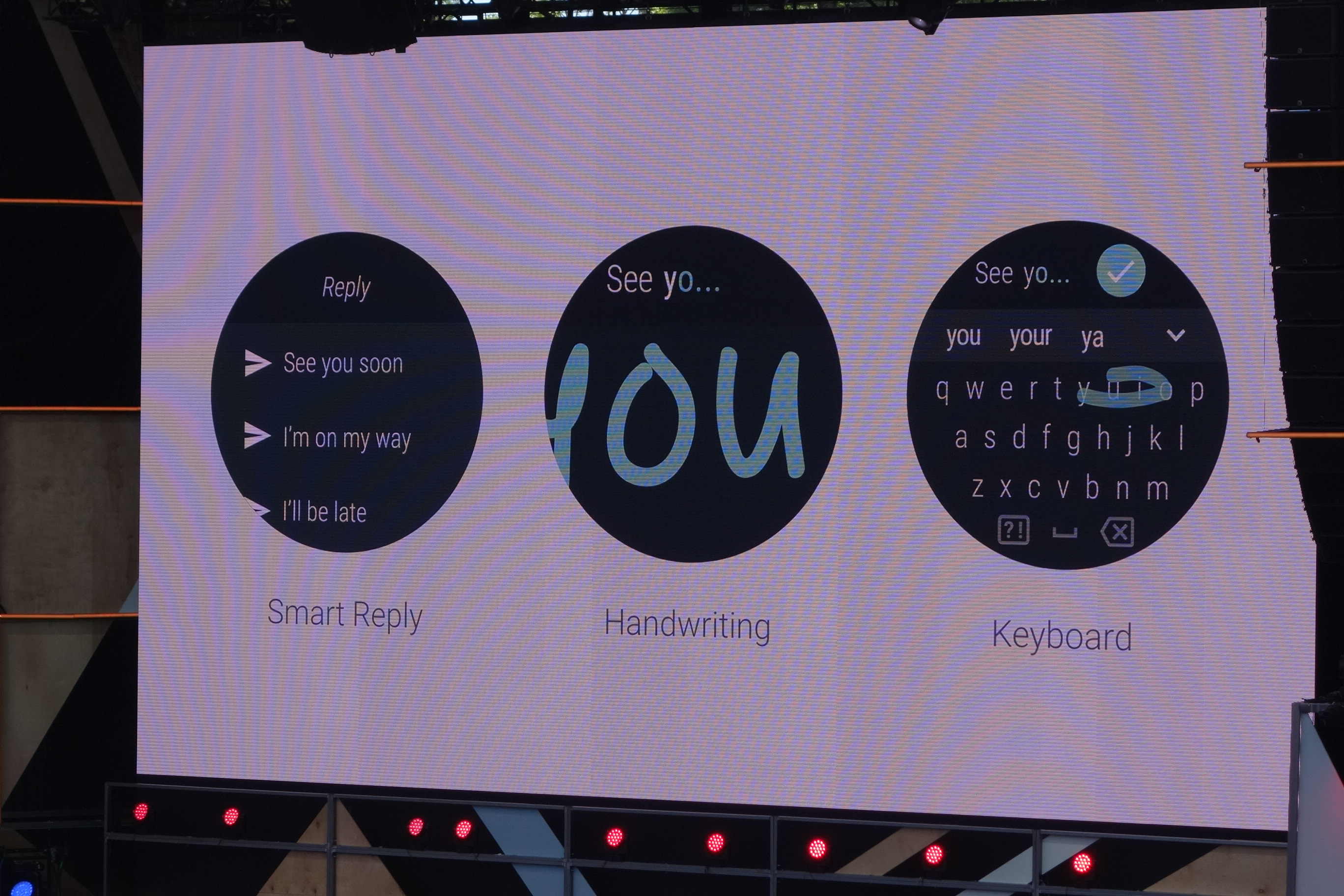

リプライをサジュエストしてくれる smart reply、 手書きを認識してくれる機能、さらにキーボードに対応しました。

動作認識によって、運動を検知し、カロリーを計算できるapiの提供、さらにスマートフォンなしで音楽も再生できます。

Android Studio 2.2

Speed, Smarts, Platform supportという観点で新機能が発表されます。

ビルドが10倍(Instant Run使用)、Emulatorが3倍早くなりました。

また自動でテスト結果を生成するようになりました。

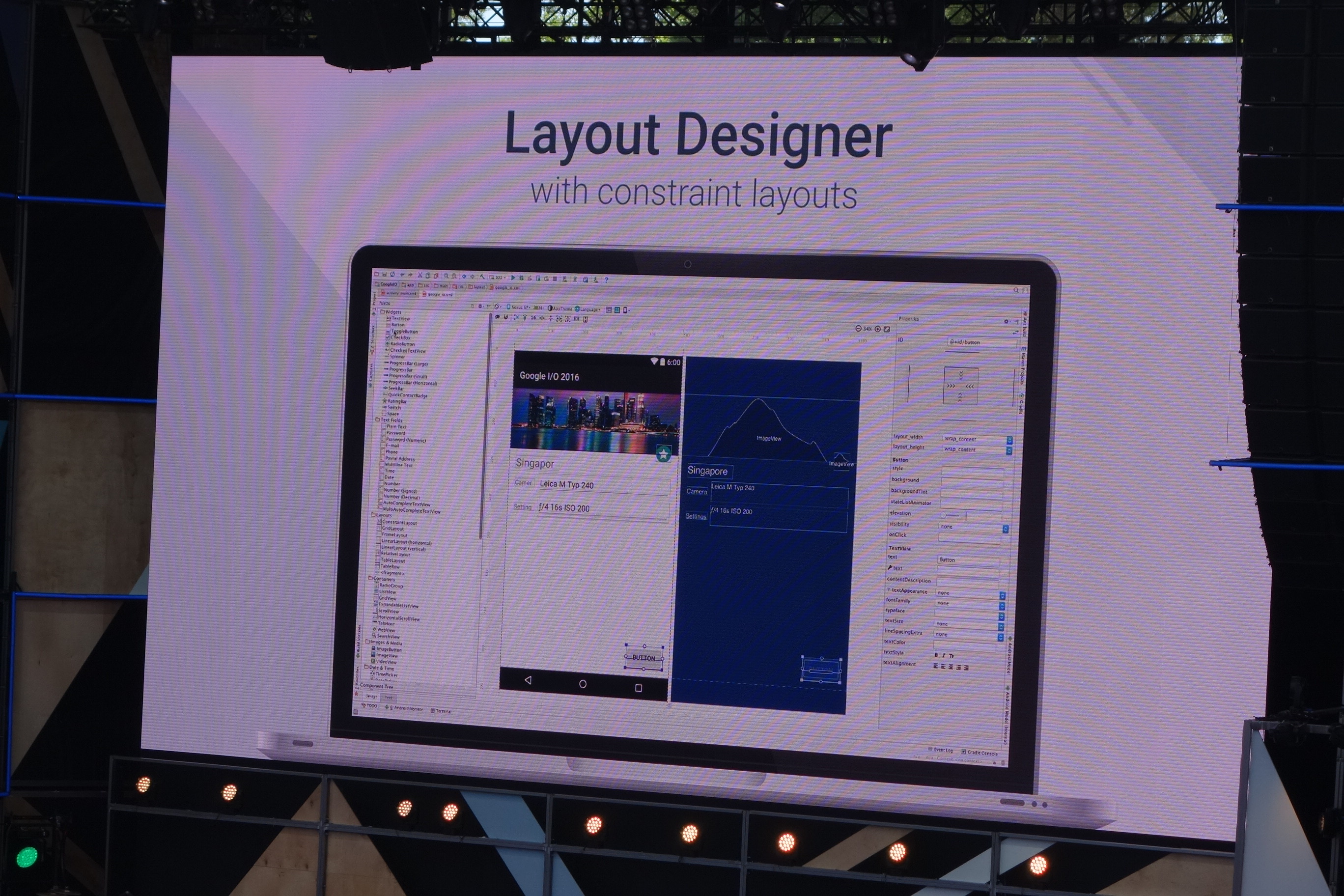

新しいLayout Designerの機能も追加されました。踏み込んだ説明はありませんでしたが、動画からは従来のものより使いやすそうな印象でした。

次にSmart観点の話です。APK AnalyzerやLayout Inspectorなど詳しい発表はありませんでしたが、そのような機能が追加されたようです。

最後にPlatform supportという観点。Jack compiler/java8のサポートが行われ、さらにNDKのサポートもより強化されたようです。

Firebaseの機能が無制限で無料に

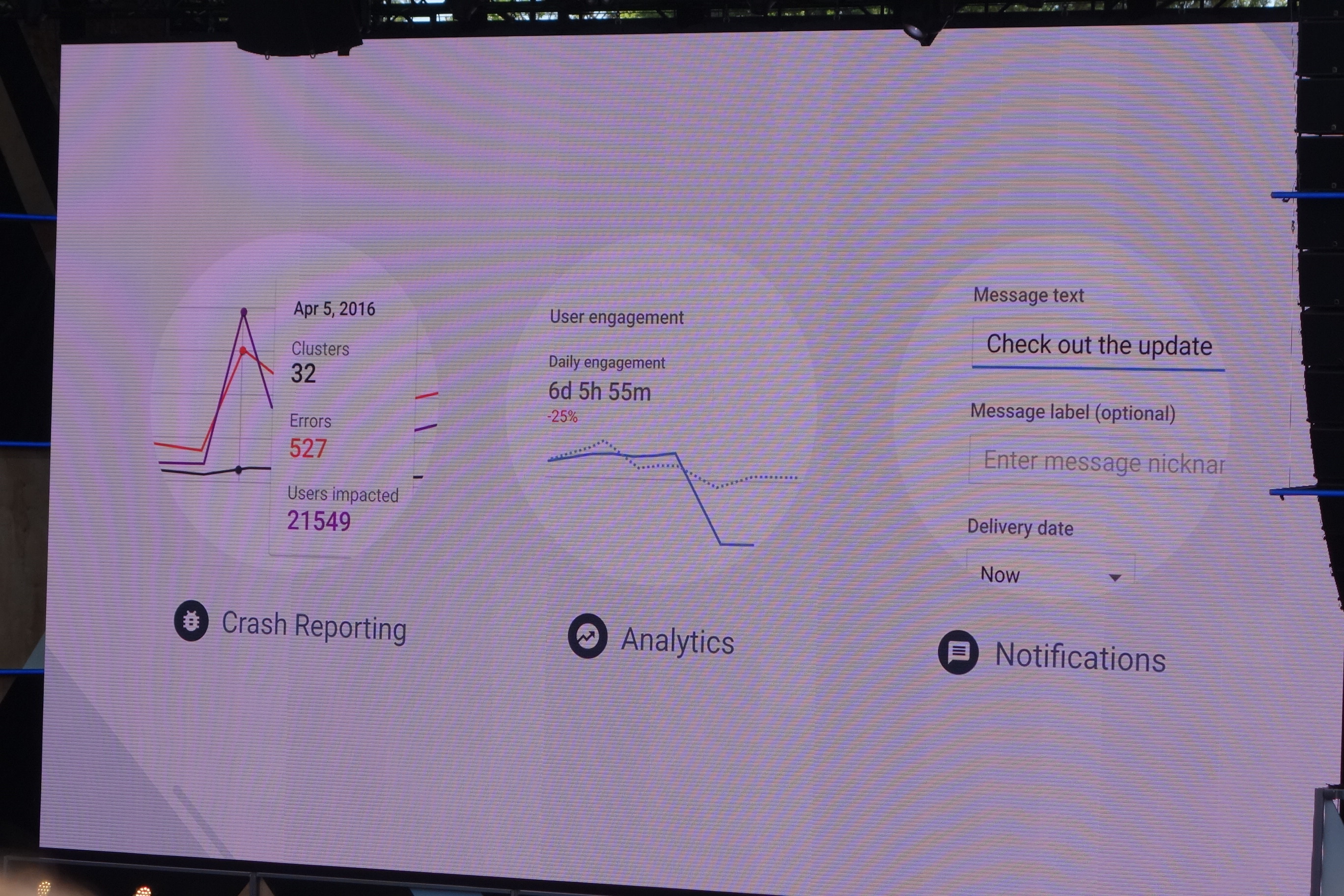

Firebase はデータベースやAPI、認証プロセスといったほぼすべてのアプリケーションに共通するニーズに対応したリアルタイムアプリケーション用のプラットフォームです。このようにこれまではアプリ / サービス開発プラットフォームとしての側面が強かったですが、なんと今までGoogle Analyticsで行っていたような分析がFirebase上でも出来るようになりました。しかも無料かつ無制限で利用可能!

他にもクラッシュレポートの取得や通知を送ることもできるようです。これらももちろん無制限で無料。

Android Instant apps - インストール不要でアプリが使える

インストール不要でアプリを使うことができる Instant appsについての発表がありました。

webで検索してリンクをクリックすると、インストールしていないアプリの機能を使うことができます。例えば上の例ではそのままバッグを購入するところまでできていました。

最後に - 機械学習を含めた未来について

最後に改めてCEOから現在進行中のプロジェクトについて発表がありました。

まずはオープンソースのプロジェクトである Tensorflow と Natural language parser (こちらは先週公開済み ) の二つの紹介。

上の写真では、Deep learningを用いてロボットが大きさの異なるものを取れるようになる様子が紹介されていました。

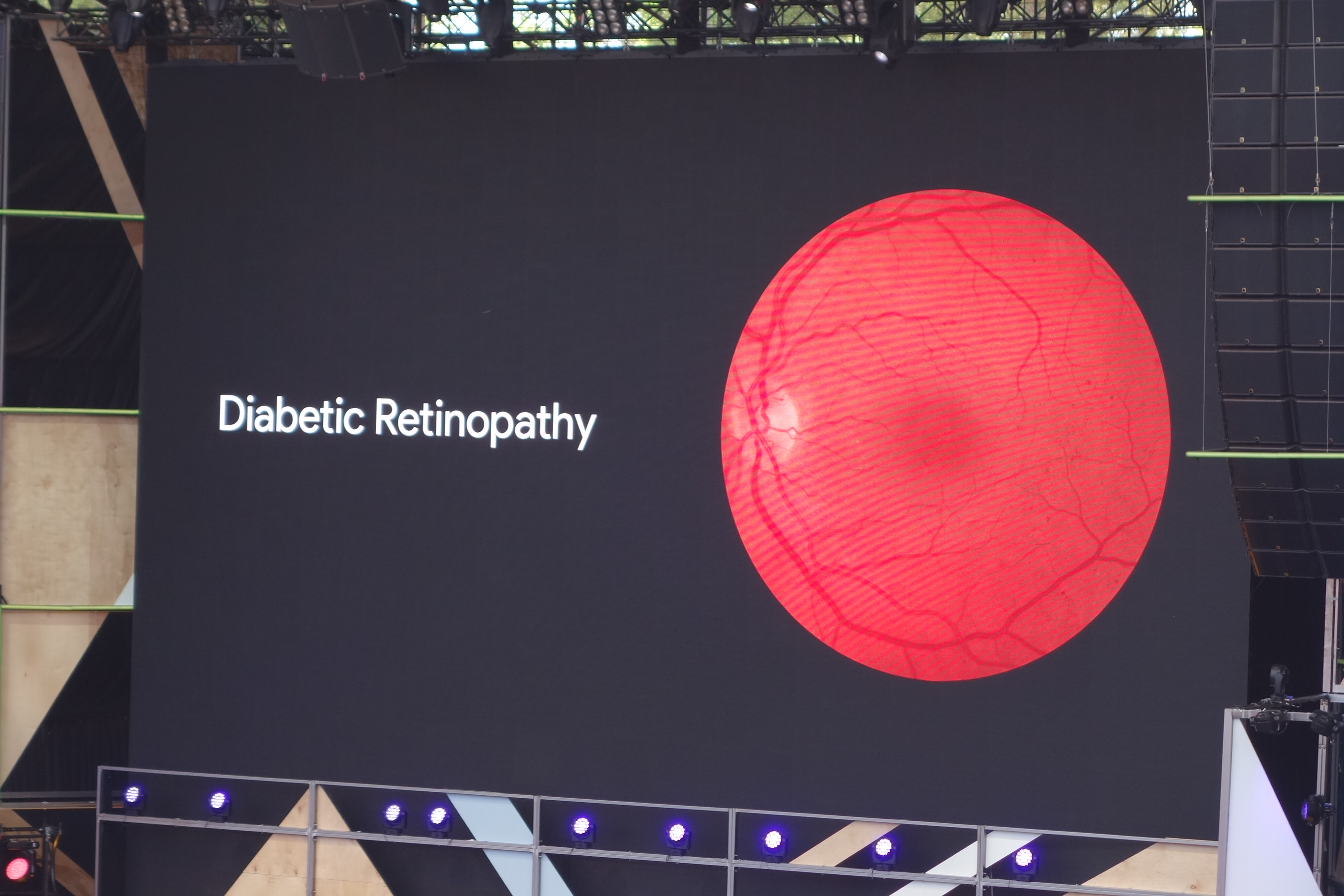

こちらは始まったばかりのプロジェクトですが、発見の難しい糖尿病網膜症をDeep Learningを用いて早期に発見するということも行っているとのことでした。

以上で基調講演は終了です。開催前の予想通り機械学習を用いたプロジェクトの紹介が多くを占めていました。個人的に最後の糖尿病網膜症の早期発見に関してはかなりの期待をよせています。