目次

こんにちは、ホットペッパーグルメAndroid開発の朱と申します。

5/17~19日、サンフランシスコで開催されたGoogle I/Oに参加してきました。同じ部門の小川さんと段さんも一緒です!

そして、カンファレンスで私が感じた、特にAndroidエンジニアとしての印象深かったポイントを紹介したいと思います。

紹介・カンファレンスのポイント

去年と同じく、今回もSilicon ValleyのShoreline Amphitheatreをメイン会場として開催されました。

シンプルなリュックとTシャツを特徴とした7500人以上のgeekたちがそこに集まり、世界的に新しい技術について交流をしました!

まず最初の刺激はKeynoteのOpening Animationから始まりました。

小さなアイディアの卵が、ブラッシュアップされていき、様々な人の手を借りて、最終的には大きな銀河になりました!

Googleはこの途中の協力者になりたい、というコンセプトです。

「What will your idea become?」

カンファレンス全体から見ると、ポイントは以下の二つだと思います。

- 「AI first」を攻めて進んでる

- 音声と写真の時代が来た

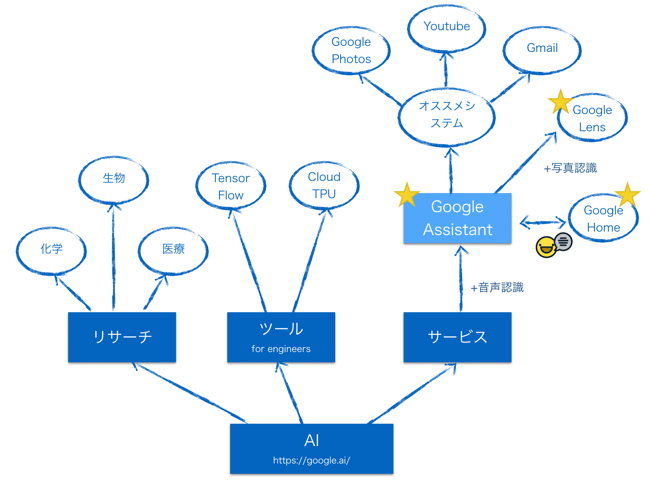

「Mobile first to AI first」 をテーマとして、GoogleはAIを中心に着実に進歩していっています。

Cloud TPUに基づき、新しいMachine Learningシステムのトレーニング時間は1/8に削減できます。

更に、リサーチと開発者向けのツールだけではなく、Google自身のサービスは全てAIを利用した強大なサービスネットワークを展開しています。

その中心は、既にAndroid/iOSにリリースされているGoogle Assistantです。

世界中の様々なPlatformで、世界中の様々なAPIを提供し、ユーザーの生活と仕事を全面的にアシストしています。

他にも、Google I/Oの一週間後に流れた、囲碁のAI AlphaGo が世界一の棋士柯潔に勝ったというニュースは、GoogleのAIのレベルがもはや人類最高峰の頭脳にも勝てるレベルになってきているという事を証明する一つの事例と言えるのではないでしょうか。

A lot of the future of search is going to be about pictures instead of keywords.

——– Ben Silbermann, Pinterest Founder / CEO, 4/17

「Hands Free」 を実現する未来のinterfaceは音声と写真でしょう。

Googleはそう考えて、音声認識と画像認識の研究はかなり深くまで進んでいます。

例えば、音声認識の錯誤率は4.9%以下に抑えられています。(これは人間より低い数値です!)

現地のSandboxで体験したGoogle Assistantのデモも、すごく賑やかな環境かつかなり安いearphoneでもちゃんと言葉を認識してくれました。

Google Assistantは、既にGoogleの色々なサービスと繋がっています。

更には世界中のエンジニアたちにAPI開発を鼓舞していて、Siriの良いライバルになるでしょう。

(interfaceとしてのGoogle Homeの発表もありました)

そして話題になっているGoogle Lensは

- 写真の邪魔な物を自然に削除する

- 花の具体的な種類を表示する

- 街をスキャンすると様々な店の情報と評価を表示する

- 看板の文字を自動的に翻訳する

など、AIと強力な画像認識を組み合わせることで驚くべきサービスを実現しています。

Android開発について

Google I/Oの最後のセッションが終わった後、現地で出会ったAndroidエンジニアと会場を出るときに以下のような会話をしました

「次はなにをするつもり?」

「そろそろMachine Learningをやってみたいね〜」

…Android開発に対する熱量は下がってしまったのでしょうか?

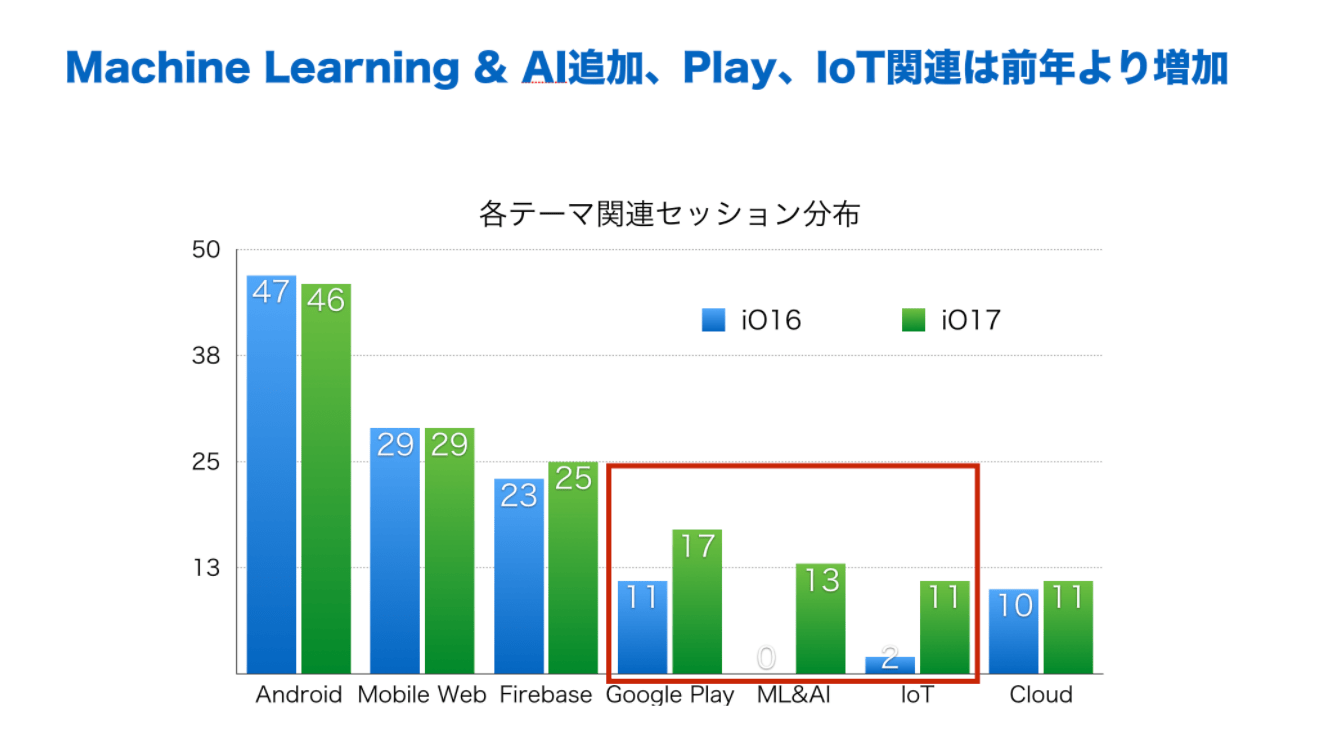

各テーマの関連セッション分布を見てもわかる通り、ライジングスターAIとIoTなどの発展速度はとても速いです。

それでも、AndroidはGoogleの基本ベースとして、相変わらず一番多いセッション数がありました。

今回Androidに関する発表として、Kotlinのサポート、Android Studio 3.0とfirebaseの更新など、開発者の効率をあげるためにかなりの力を入れたことがわかります。

更に、Android ThingsとAndroid Goを代表として、軽量デバイス向けのツールもどんどん進歩しています。

Kotlin

今回、会場で一番盛大な拍手が上がったのは、Kotlinの公式サポートが発表された瞬間です!

Kotlinも含めて、IntelliJ、 Android Studio、PyCharmなどを提供しているJetBrains社が品質と安定性を保証していると共に、既にオープンソース化もされています。

Javaより40%行数が減らせる(JetBrainsにより)、Javaで一番困っているNullPointerException問題が解消される、Javaと100%互換できる 等、開発者として大きなメリットがあります。

Android Studio 3.0 Canary

2.3.Xバージョンから3.0バージョンになり、今回Android Studioの更新内容はかなり多かったです。

通常開発に関して

新しい言語Kotlinがサポートされたことで、Androidはやっと自分の言語を手に入れたことになります!

Kotlinをサポートし全体効率は大幅に上がる一方で、layout / fonts / Iconのデザインについての編集ももっと楽になっています。

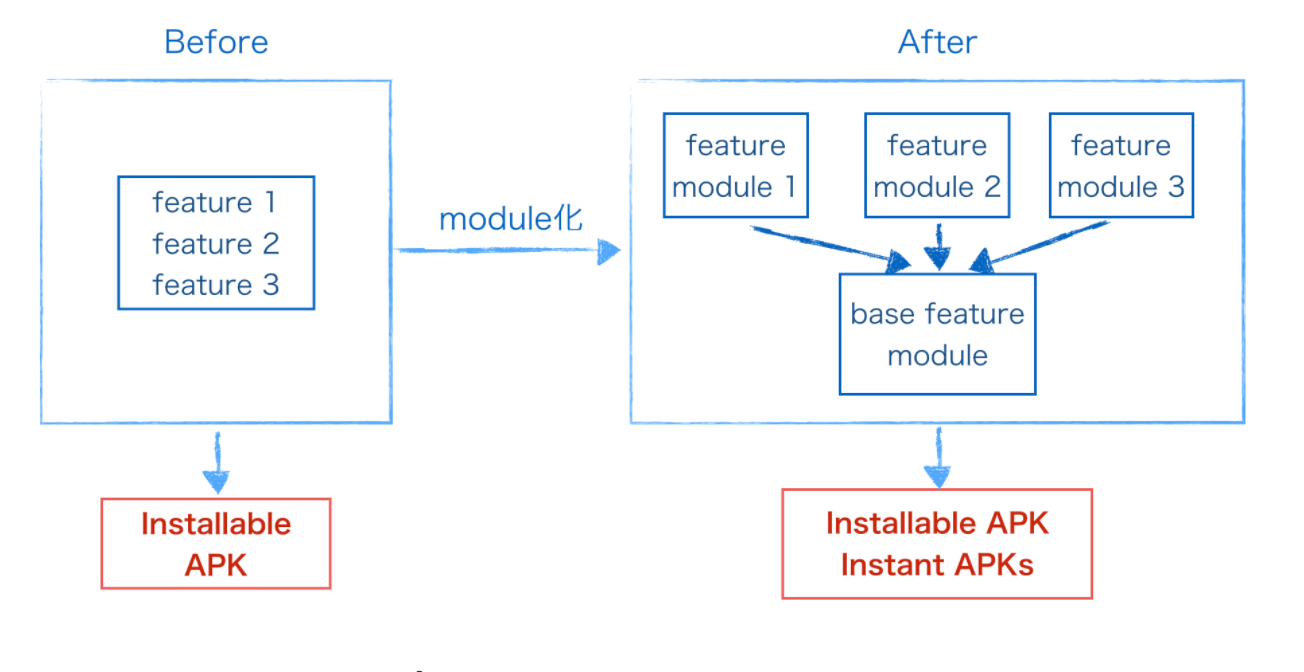

Instant Appsのサポート

去年発表されたInstant Appsはインストールなしで、すぐアプリが利用できる機能です。

裏の仕組みとしては、リンクをクリックするとGooglePlayからソースを端末上にダウンロードし、アプリを直接起動、アプリを閉じるとデータを削除します。

この一年間でGoogleは限定的なパートナーたちと協力して実際のサービスのテスト/調整を行い、ついに全ての開発者に公開されました!

Instant Appsは現状Android 6.0以降のデバイスに提供されていますが、今後は更に多くのデバイスに提供する予定があるようです。

Instant Appsをきっかけに、これからアプリとウェブサービスの差もどんどん埋まっていくのではないかと思います。

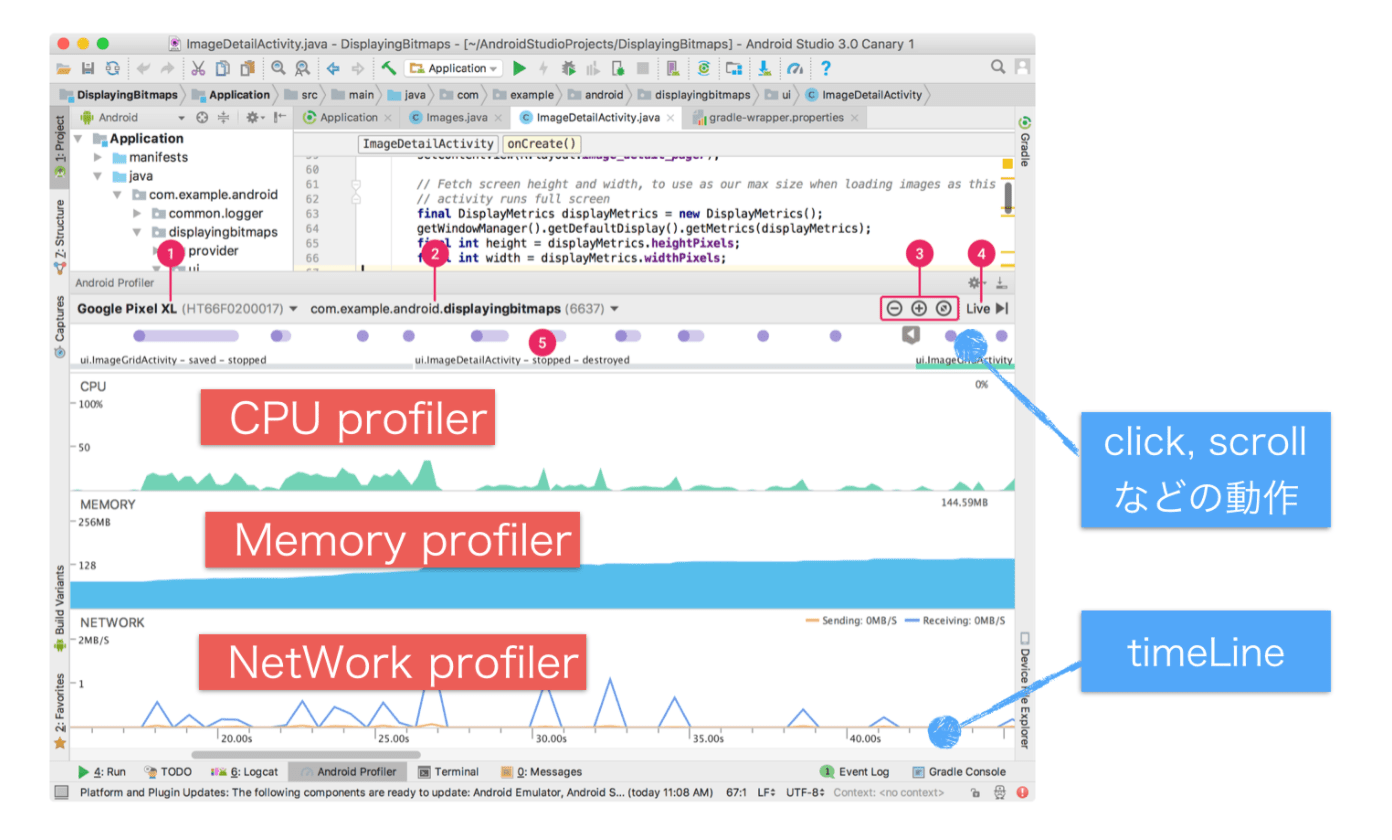

Debugツール:Android Profiler

アプリ品質担保のためのリアルタイムDebugツール、Android Profilerは大きく改善されました。

開発者はローカルDebugする際、CPU / メモリー / ネットワークの状態を全て把握でき、問題が発生した場合に、メソッド単位まで細かくターゲットにできます。

開発者がもっと楽に開発できるようになる以外にも、Android O、 Android Things とAndroid Goの更新など、Androidの発展は軽量デバイスからAI チップを含めるデバイスまでにサポートを広げています。

他にも、強力なプラットフォームFirebaseとGoogle Cloud Platformの提供、Google Play 管理ツールの全体更新のおかげで、開発者は自分のコーディングだけに集中することができます。

これからのAndroid開発で、どのようにAIや画像認識、音声認識などのAPIを利用して新しいサービスを作るのかは我々の使命と言えるでしょう!

サンフランシスコの雰囲気

今回、三日間のカンファレンスを含めて一週間サンフランシスコで過ごしました。

この世界的に賢いエンジニアたちが集まってる町の雰囲気としては シンプルな生活だけど、技術意識がさすがに高い ということです。

Uberで夜ご飯を食べる途中で、後ろのエンジニアはずっとパソコンで"パパパー"っとコーディングをしていました。

町ではTeslaが多く走っているのも見かけました! そのせいかほとんどの駐車場にはTesla用の充電器が設置されていて、さすがシリコンバレーという印象です。

道を間違えた場合1秒で新しいルートをオススメする、自動的に周りの車との距離を判断する、自動的に車庫に入れるなどの機能を見ると、一瞬SF映画の中にいるみたいだと錯覚してしまいました。

Uber、自転車シェアのようなアプリの利用率は想像以上に高いです。

美術館のアプリは、GPSで作品の前に立ったら関連する紹介が自動的に流されました。認識の精度にびっくりしました。

交流したエンジニアたちの家にはAmazon Alexa / ゴミ箱のセンサー / 車庫のセンサー 等、IoTもかなり導入されていました。

かにも美味しかったです!

最後の小噺と終わりに

ご存知の方もいると思いますが、実はGoogleの検索、メールなどのメイン機能は中国で利用出来ません。

今回現地でGDG(Google Developer Group) Chinaのエンジニアたちとも出会いました。

彼らはAI、Firebase、Android Thingsなどの新しい技術を中国に導入出来るように活躍しています!

自分もこれから学んだ技術と素晴らしいエンジニアたちのやり方を業務で実現してみたいです!

P.s. Google I/Oで発表したスピーチはこちらで見れますので是非覗いてみてください。